Einleitung: Die Genesis einer präzisionsgetriebenen Scan-Revolution

In der dynamischen und stets sich transformierenden Sphäre der digitalen Bildverarbeitung etabliert sich das Projekt Bild/Papier-Scanner als ein bahnbrechendes Monument wissenschaftlicher Ingeniosität, das die Grenzen der Unstimmigkeitserkennung und -korrektur in gescannten Medien neu definiert. Dieses ambitionierte Vorhaben integriert hochentwickelte Machine-Learning-Paradigmen, insbesondere eine intricately gestaltete Autoencoder-Architektur, um die vielschichtigen, multidimensionalen Ebenen textueller und mikroskopischer Daten in einer Vielzahl von Medienklassen – von Polaroid über Fotopapier bis hin zu historischen Drucken – mit chirurgischer Präzision zu entschlüsseln. Während wir die technischen Fundamente und algorithmischen Nuancen dieses Projekts ergründen, offenbaren sich tiefgreifende Implikationen für die Bereiche der digitalen Archivierung, forensischen Bildanalyse und der restaurativen Kunstpflege, die das Potenzial haben, die Disziplinen der Bildwissenschaft nachhaltig zu transformieren.

Zielsetzung 1: Erkennung von Unstimmigkeiten mit mikroskopischer Präzision

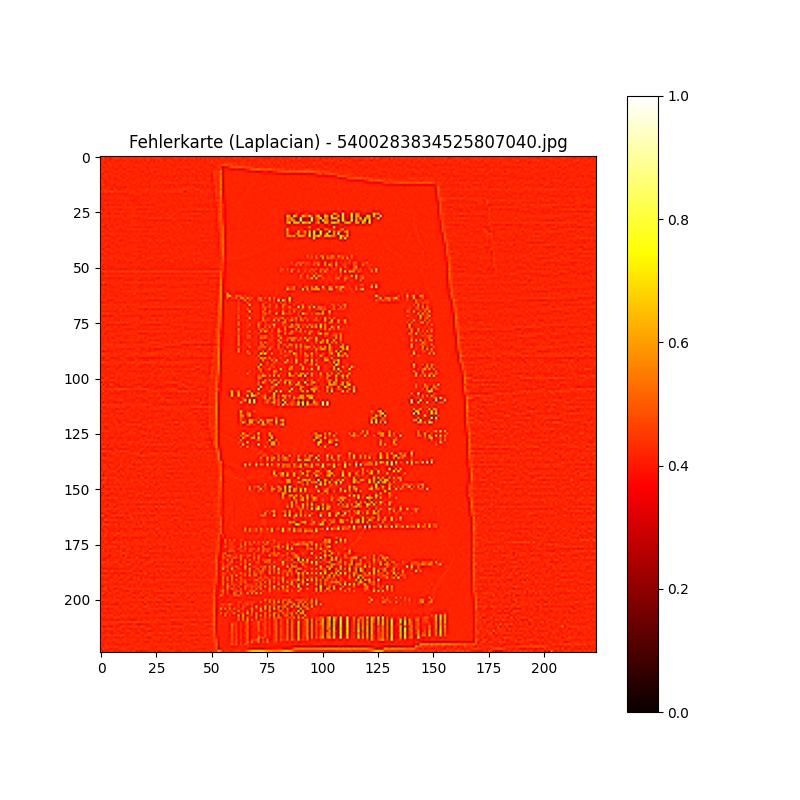

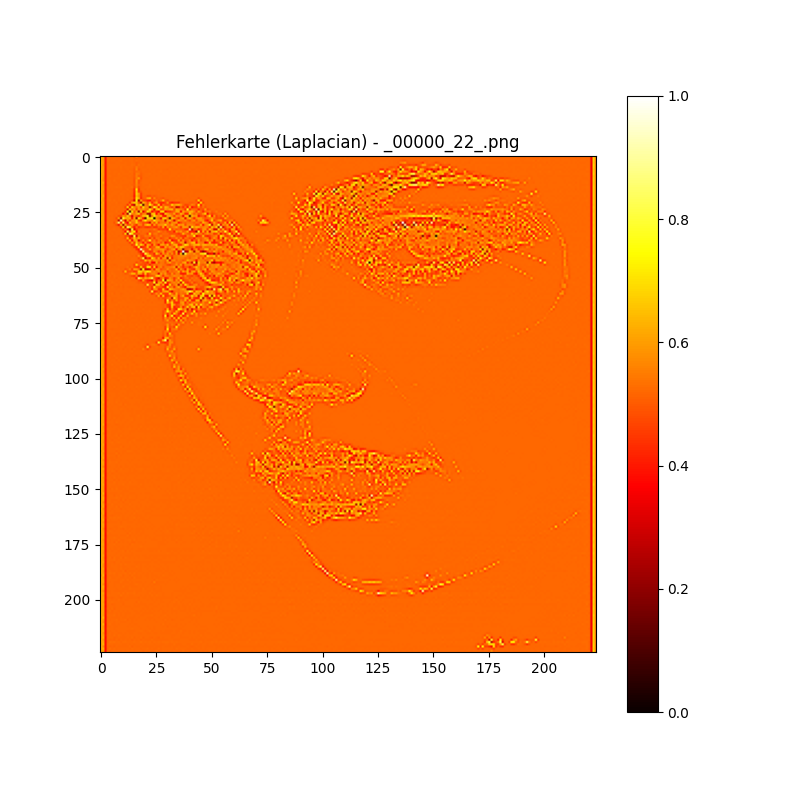

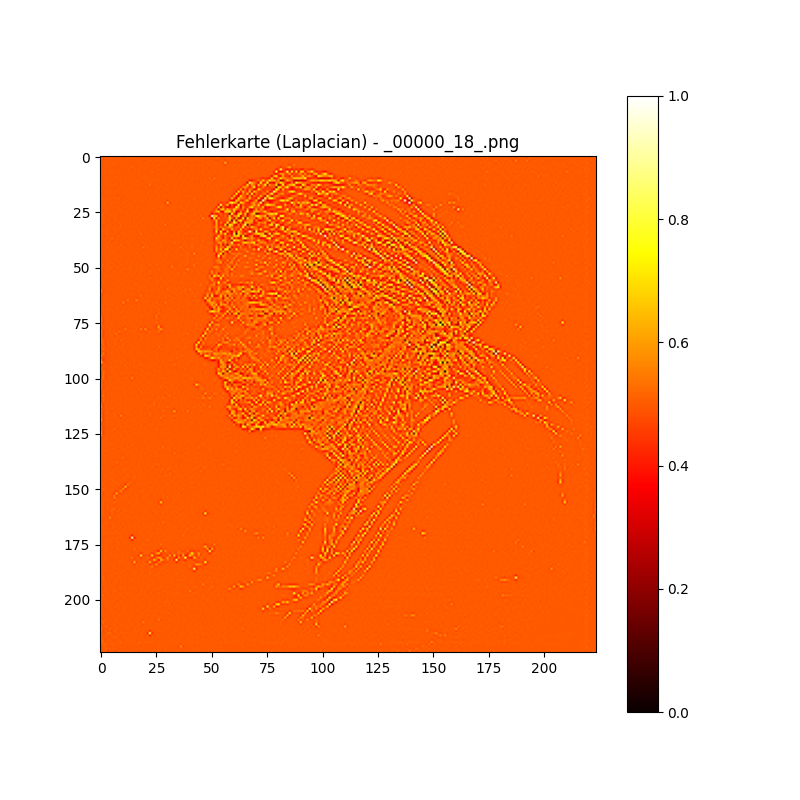

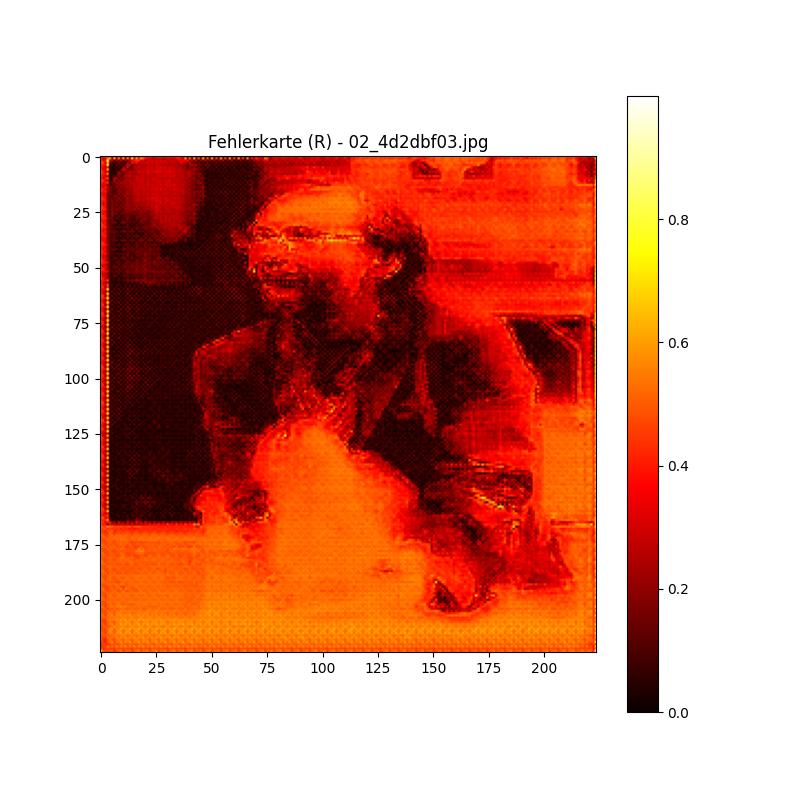

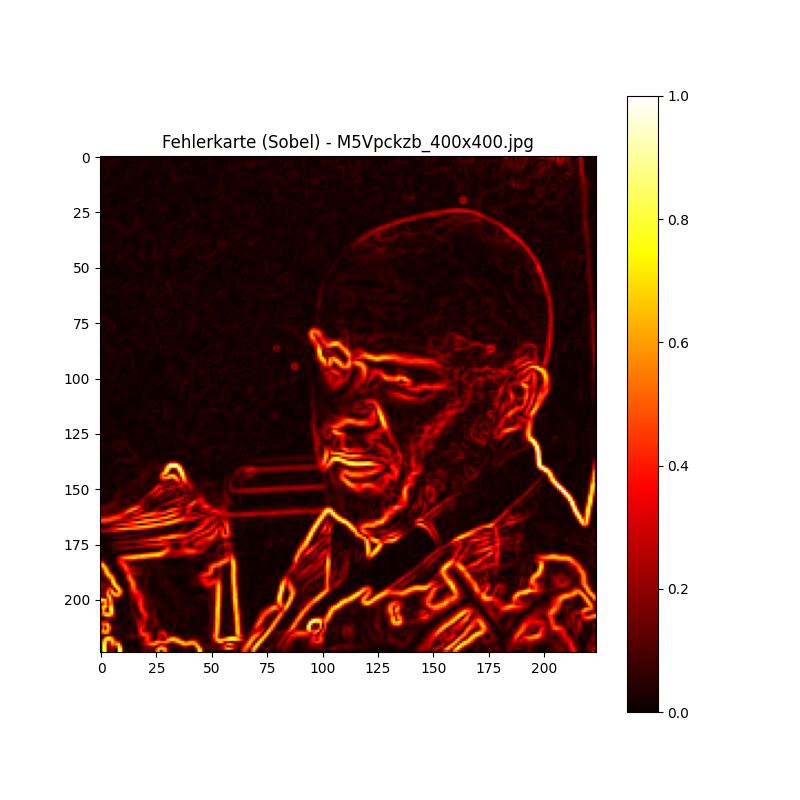

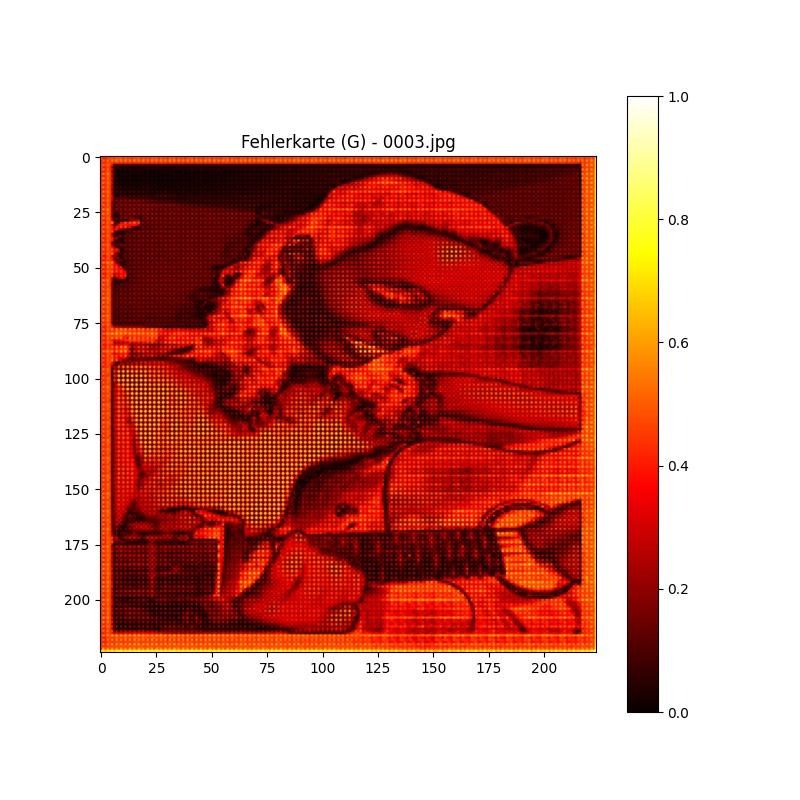

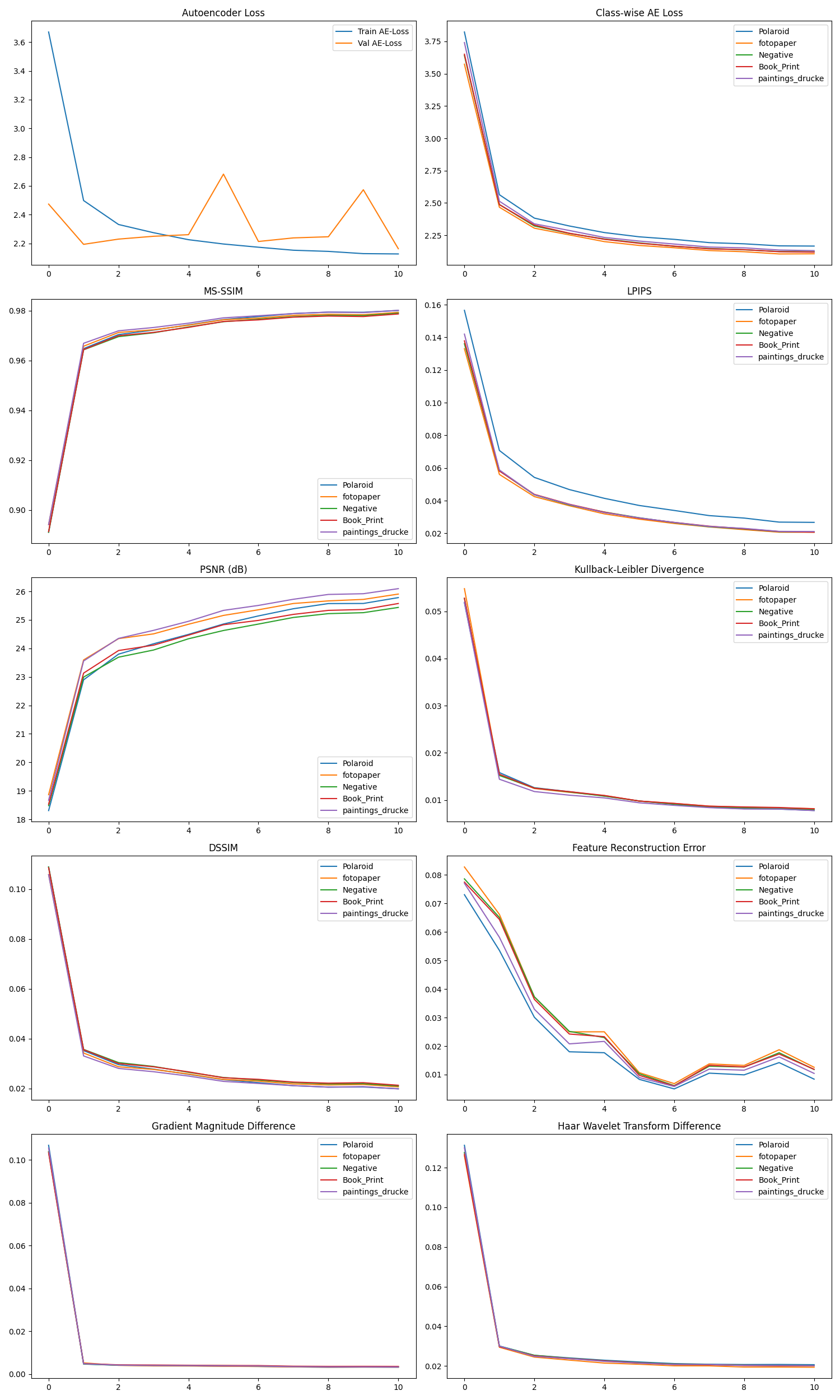

Das zentrale Anliegen des Bild/Papier-Scanners manifestiert sich in seiner unerschütterlichen Mission, Unstimmigkeiten quer durch ein heterogenes Spektrum gescannten Mediens mit einer Präzision zu identifizieren und zu korrigieren, die an chirurgische Exaktheit grenzt. Ob es sich um diffuse Verzerrungen in den pigmentierten Schichten eines Polaroid-Drucks, die subtilen chromatischen Aberrationen auf vergilbtem Fotopapier oder die mikroskopischen Risse in emulsionbedeckten Negativfilmen handelt, dieses System nutzt ein raffiniertes Autoencoder-Framework, um Anomalien mit einer Detailtiefe aufzuspüren, die über die Kapazitäten konventioneller Bildverarbeitung hinausgeht. Die Trainingsmethodik wird durch eine konvergente Anwendung fortgeschrittener Bewertungsmetriken wie dem Mean Structural Similarity Index (MS-SIM), dem Learned Perceptual Image Patch Similarity (LPIPS), dem Peak Signal-to-Noise Ratio (PSNR) und der Kullback-Leibler-Divergenz bereichert, die kollektiv eine quantitative Bewertung der Bildintegrität ermöglichen. Die in unseren diagnostischen Visualisierungen dokumentierten Daten zeigen eine markante Abnahme der Fehlerquoten bei steigenden Parametergrenzen, was auf eine adaptive, nichtlineare Lernkurve hinweist, die die Erkennung von Unstimmigkeiten auf subpixelarer Ebene perfektioniert und somit eine neue Ära der qualitativen Bildrekonstruktion einleitet.

Zielsetzung 2: Ein monströses Trainingskorpus als Fundament der Exzellenz

Die unerschütterliche Robustheit des Bild/Papier-Scanners wurzelt in einem monströsen Trainingskorpus, das mit akribischer Sorgfalt zusammengestellt wurde und etwa 50.000 Medienseiten pro Klasse umfasst. Dieser kolossale Datenschatz erstreckt sich über eine taxonomische Bandbreite von Kategorien – Polaroid, Fotopapier, Negative, Book_Print und paintings_drucke – wobei jede Klasse einer stringenten Vorverarbeitung unterzogen wird, um die inhärente Variabilität texturaler Profile, Pigmentierungsgrade und Abbau-Muster abzubilden. Die immense Größe dieses Datensatzes befähigt ein tiefes neuronales Netzwerk, generalisierte Mustererkennungsmodelle zu entwickeln, die über die spezifischen Eigenheiten einzelner Medientypen hinausgehen und eine adaptive Diskriminierung ermöglichen. Die iterative Optimierung, wie sie in den komplexen Verläufen der Gradientenmagnitudendifferenzen und den vielschichtigen Wiederherstellungsfehlern widergespiegelt wird, unterstreicht die Fähigkeit des Systems, sich asymptotisch einem Zustand minimalen Verlusts anzunähern – ein klares Indiz für die überragende Skalierbarkeit und die heterogene Diversität des Trainingsmaterials. Diese datengetriebene Grundlage positioniert den Scanner als eine unverzichtbare Ressource für die Erforschung komplexer Bildphänomene.

Zielsetzung 3: Texturale und mikroskopische Meisterschaft auf molekularer Ebene mit kalibrierbarer Präzision

Das Projekt steigt auf ein unvergleichliches Niveau der analytischen Exzellenz, indem der Bild/Papier-Scanner gezielt auf die synergetische Analyse texturaler und mikroskopischer Ebenen trainiert wird, die die Grenzen der konventionellen Bildverarbeitung sprengen. Durch die innovative Integration von Haar-Wavelet-Transform-Differenzen, die die Frequenzkomponenten der Bildtexturen aufspalten, und der Gradientenmagnitudedisparitäten, die topografische Konturen auf subpixelarer Ebene abbilden, zerlegt das System die intricaten Strukturen gescannten Mediens mit einer Präzision, die an molekulare Analysen erinnert. Ein herausragendes Merkmal dieser Architektur ist ihre kalibrierbare Natur, die es ermöglicht, das Modell spezifisch auf die einzigartigen Anforderungen verschiedener Medien anzupassen – sei es die fragile Pigmentstruktur alter Gemälde, die feinen Schichtungen spezieller Fotografien oder die komplexen Druckmuster historischer Drucke. Dieser anpassungsfähige Ansatz, gestützt auf die nuancierten Konvergenzmuster der Wiederherstellungsfehler, wie in unseren detaillierten diagnostischen Diagrammen veranschaulicht, belegt die außergewöhnliche Fähigkeit des Modells, hochauflösende, artefaktfreie Darstellungen auf einer granularen, nahezu atomaren Ebene zu rekonstruieren. Darüber hinaus deutet die modulare Struktur des Systems auf ein erweitertes Anwendungsspektrum hin, das potenziell auf die Analyse von Dokumenten, historischen Urkunden, Pergamenten und anderen ephemeren Materialien ausgedehnt werden könnte, wodurch neue Horizonte in der paläografischen und archivalischen Forschung eröffnet werden.

Schlussfolgerung: Ein Fenster in eine transformative Zukunft

Das Bild/Papier-Scanner-Projekt verkörpert eine symbiotische Verschmelzung von algorithmischer Raffinesse, datengetriebener Präzision und empirischer Strenge, die bestens gerüstet ist, die paradigmatischen Standards der digitalen Medienanalyse nachhaltig zu revolutionieren. Mit seiner unübertroffenen Fähigkeit, Unstimmigkeiten zu erkennen, einen umfangreichen Trainingskorpus zu beherrschen, texturale-mikroskopische Feinheiten auf molekularer Ebene zu meistern und eine kalibrierbare Anpassung an spezifische Medien wie Gemälde, Fotografien und Drucke zu ermöglichen, kündigt diese Technologie eine neue Ära der Bildwissenschaft an, die die Grenzen der menschlichen Wahrnehmung und der maschinellen Intelligenz neu auslotet. Die visionäre Ausweitung auf Dokumente, Urkunden und andere historische Artefakte verspricht, die Methodik der kulturellen Erhaltung und historischen Rekonstruktion zu transformieren, während wir die Algorithmen weiter verfeinern, den Datensatz erweitern und die Anwendungsszenarien diversifizieren. Das Potenzial für transformative Auswirkungen über Branchengrenzen hinweg – von der Kunstrestaurierung über die technologische Innovation bis zur paläografischen Forschung – bleibt unbegrenzt. Bleiben Sie dran, um weitere Einblicke in diese bahnbrechende Innovation zu gewinnen, die die Zukunft der digitalen Bildverarbeitung prägen wird.

Analyseergebnisse: Fakes (KI-generiert)

Analyseergebnisse: „Non-Fakes“ (Digital/Print gemischt)

Schreibe einen Kommentar