Der DNID-Deepfake-Scanner für Videos, zugänglich unter https://dnid.me/, ist ein Werkzeug, das jedes einzelne Frame eines Videos auf seine Pixel-Konsistenz hin überprüft. Ziel ist es, Manipulationen in Videomaterial zu erkennen und so die Authentizität von Inhalten zu überprüfen. In einer Zeit, in der digitale Inhalte zunehmend durch Deepfake-Technologien gefährdet sind, kann der Scanner dazu beitragen, die Integrität von Videos in Bereichen wie Nachrichten, Unterhaltung oder rechtlichen Kontexten zu bewahren. Die Verbreitung von Deepfakes bringt jedoch erhebliche Probleme mit sich: Sie können Desinformation verbreiten, Persönlichkeitsrechte verletzen, das Vertrauen in Medien untergraben und in kriminellen Kontexten wie Erpressung oder Identitätsdiebstahl eingesetzt werden. Besonders problematisch ist ihr Einfluss auf die öffentliche Meinung, etwa durch gefälschte Aussagen von Politikern oder Prominenten, was demokratische Prozesse gefährden kann. Ein Bericht des Bundesamts für Sicherheit in der Informationstechnik (BSI) aus dem Jahr 2023 beschreibt, wie Deepfakes zur Verbreitung von Fake News genutzt werden (BSI-Bericht 2023). Zudem können sie psychologische Schäden verursachen, insbesondere wenn intime Inhalte ohne Zustimmung manipuliert und verbreitet werden, wie eine Studie der Universität Oxford über die sozialen Auswirkungen von Deepfakes zeigt (Oxford Study on Deepfakes). Darüber hinaus berichtete die Tagesschau im Januar 2025 über einen Fall, in dem ein Deepfake-Video eines CEOs für eine betrügerische Millionenüberweisung missbraucht wurde, was die wirtschaftlichen Risiken verdeutlicht (Tagesschau: Deepfake-Betrug).

Für die Entwicklung des Systems wird eine maßgeschneiderte und gründlich trainierte Künstliche Intelligenz (KI) eingesetzt, die auf aktuellen wissenschaftlichen und technologischen Erkenntnissen basiert. Das Modell sowie das grundlegende Konzept stammen von mir, unterstützt durch umfassende Datensätze und Trainingsmethoden. Das System wird kontinuierlich weiterentwickelt, um mit den sich wandelnden Herausforderungen der Deepfake-Technologie Schritt zu halten. Diese Weiterentwicklung umfasst Updates, die etwa 1-2 Mal pro Monat vorgenommen werden, um den Scanner aktuell zu halten.

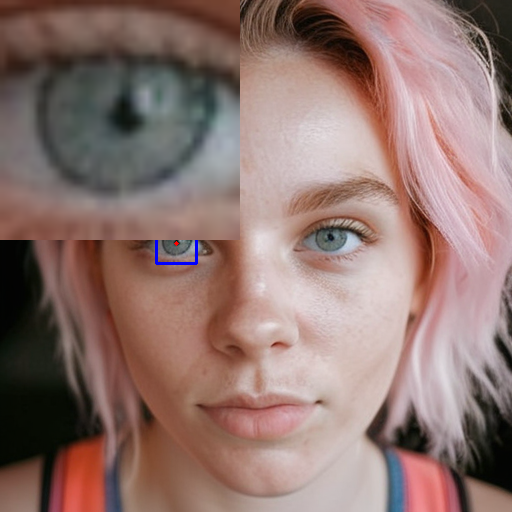

Die Methode basiert auf einem einfachen Prinzip: Wenn ein Frame in einem Video manipuliert wurde, zeigen die veränderten Bereiche Abweichungen in der Pixelstruktur im Vergleich zum Rest des Bildes. Diese Unterschiede werden genutzt, indem die Frames einer detaillierten Analyse unterzogen werden. Dabei werden mehr als nur oberflächliche Merkmale geprüft; es kommt zu einer umfassenden Untersuchung, die zwölf verschiedene Metriken umfasst. Dazu gehören Aspekte wie Farbverläufe, Lichtverhältnisse, Texturmustern, Bewegungsvektoren und temporale Veränderungen im Video. Diese Metriken wurden ausgewählt, um auch subtile Manipulationen zu erkennen, die durch moderne Deepfake-Techniken entstehen können.

Die Leistung des Scanners wird durch verschiedene Analysen und Daten belegt, wie sie in den beigefügten Diagrammen ersichtlich sind. Die Confusion Matrix für CatBoost mit einem Schwellenwert von 0,5 zeigt beispielsweise, dass von 2.067.998 analysierten Frames 536.218 Nicht-Deepfake-Frames korrekt erkannt wurden (25,9 % der Nicht-Deepfake-Daten), während 1.180.188 Deepfake-Frames richtig identifiziert wurden (57,1 % der Deepfake-Daten). Die Gesamtgenauigkeit beträgt 83 %, was auf eine solide Leistung hinweist. Allerdings weisen die 186.865 falsch positiven und 164.727 falsch negativen Klassifikationen darauf hin, dass es noch Verbesserungsmöglichkeiten gibt, insbesondere angesichts der Komplexität moderner Deepfake-Algorithmen.

Die Korrelations-Heatmap für CatBoost-Daten verdeutlicht die Beziehungen zwischen Features wie „Deepfake Score“, „Avg Magnitude“ oder „Temporal Magnitude Change“. Eine starke Korrelation zwischen „Deepfake Score“ und „Extended Deepfake Score“ (1,0) zeigt, dass diese Metriken eng miteinander verbunden sind und wichtig für die Erkennung sind. Auch „Histogram Symmetry“ und „Temporal Magnitude Change“ weisen signifikante Korrelationen auf, was ihre Relevanz für die Modellgenauigkeit unterstreicht und hilft, versteckte Spuren von Manipulationen zu finden.

Die Feature Importance für CatBoost zeigt, welche Metriken am stärksten zur Entscheidung beitragen. Der „Extended Deepfake Score“ hat einen Wichtigkeitsscore von 51,31, gefolgt von „Histogram Symmetry“ mit 27,34. Andere Metriken wie „Regional Difference“ (0,672) spielen eine geringere Rolle, was darauf hindeutet, dass das Modell auf bestimmte Schlüsselmerkmale setzt, die optimiert werden können.

Die Lernkurve für CatBoost veranschaulicht die Genauigkeitsentwicklung während des Trainings. Die Trainingsgenauigkeit variiert zwischen 0,8290 und 0,8315, während die Validierungsgenauigkeit ähnliche Werte zeigt, was auf eine stabile Leistung hinweist. Die leichten Schwankungen deuten darauf hin, dass das Modell weder über- noch unterangepasst ist, und die Trainingszeit von 79,15 Sekunden unterstreicht die Effizienz des Ansatzes.

Die ROC-Kurve (AUC = 0,914) und die Präzisions-Recall-Kurve (AUC = 0,954) bieten weitere Einblicke in die Klassifikationsqualität. Die ROC-Kurve zeigt eine deutliche Überlegenheit gegenüber einem Zufallsmodell (AUC = 0,5), und die hohe AUC-Wert der Präzisions-Recall-Kurve verdeutlicht, dass das Modell sowohl Präzision als auch Recall ausbalanciert – ein wichtiger Aspekt bei der Deepfake-Erkennung, wo falsche Klassifikationen schwerwiegende Folgen haben können.

Um die Zuverlässigkeit des Scanners zu sichern, wird er regelmäßig mit den neuesten Updates führender KI-Engines getestet. Er muss sich den Herausforderungen moderner Deepfake-Technologien stellen, die durch ihre Fähigkeit, menschliche Gesichtszüge und Bewegungen nahezu perfekt nachzuahmen, besonders problematisch sind. Diese Technologien können nicht nur individuelle Opfer betreffen, sondern auch gesellschaftliche Strukturen destabilisieren, indem sie das Vertrauen in digitale Medien erschüttern. Mit Updates etwa 1-2 Mal pro Monat wird versucht, die Erkennungsrate zu verbessern, die aktuell bei über 80 % liegt. Dies zeigt, dass es Potenzial für weitere Fortschritte gibt, um die wachsende Bedrohung durch Deepfakes zu begegnen.

Schreibe einen Kommentar