Einführung: Deepfakes als Werkzeug der Kriminellen

Deepfakes – durch KI erzeugte, täuschend echte Medien – sind nicht nur ein Phänomen der Unterhaltung oder Politik, sondern auch ein mächtiges Werkzeug in den Händen von Kriminellen. Von Telefonbetrug mit gefälschten Stimmen über Identitätsdiebstahl bis hin zu Erpressung mit manipulierten Videos: Die Technologie eröffnet Cyberkriminellen neue Wege, ihre Opfer auszunutzen, finanziellen Schaden anzurichten und unerkannt zu bleiben. Was als technische Spielerei begann, ist heute eine reale Bedrohung für Einzelpersonen, Unternehmen und Strafverfolgungsbehörden.

Teil 1: Deepfakes in der Kriminalität

Formen des Missbrauchs: Ein breites Spektrum

Deepfakes haben die Kriminalität revolutioniert, indem sie traditionelle Betrugsmethoden mit hochmoderner Technologie kombinieren. Hier sind die Hauptbereiche, in denen sie zum Einsatz kommen:

- Voice-Cloning-Betrug:

Eine der häufigsten Anwendungen ist das sogenannte „Voice Phishing“ oder „Vishing“. Kriminelle nutzen KI-Tools wie ElevenLabs oder Descript Overdub, um Stimmen von Führungskräften, Familienmitgliedern oder Behördenvertretern zu imitieren. Ein typisches Szenario: Ein gefälschter Anruf eines CEOs fordert eine dringende Überweisung, oft unter Zeitdruck, um Zweifel zu verhindern. Solche Betrügereien sind schwer zu erkennen, da die Stimme täuschend echt klingt – selbst Nuancen wie Akzente oder Sprechpausen können nachgebildet werden (Wired über Voice-Cloning). - Identitätsdiebstahl:

Deepfakes ermöglichen es, Videos zu erstellen, die jemanden in gefälschten Situationen zeigen – etwa bei der Eröffnung eines Bankkontos oder der Beantragung eines Kredits. Mit genug Bildmaterial, etwa von Social Media, kann ein Krimineller ein Video generieren, das Sicherheitskontrollen wie Gesichtserkennung täuscht. Laut Forbes nutzen Betrüger bereits Deepfakes, um biometrische Systeme zu umgehen, was die Sicherheit digitaler Identitäten infrage stellt. - Erpressung und Rachepornos:

Eine besonders perfide Anwendung ist die Erstellung von Deepfake-Pornografie, oft ohne Zustimmung der dargestellten Personen. Laut Sensity AI machen solche Inhalte 96 % aller Deepfakes aus. Kriminelle drohen, diese Videos zu veröffentlichen, es sei denn, das Opfer zahlt Lösegeld. Besonders Frauen und öffentliche Personen sind betroffen, was zu schweren psychologischen Schäden führt (BBC über Deepfake-Pornos). - Beweismanipulation:

In Gerichtsverfahren könnten Deepfakes eingesetzt werden, um Alibis zu fälschen oder Zeugen zu diskreditieren. Ein Video, das einen Angeklagten an einem anderen Ort zeigt, könnte Zweifel an der Schuld säen – eine Taktik, die noch selten, aber technisch machbar ist (NIST über forensische Herausforderungen).

Reale Fälle: Beispiele aus der Praxis

Die reale Welt zeigt bereits, wie gefährlich Deepfakes in der Kriminalität sind:

- CEO-Betrug in Großbritannien (2019):

Ein britisches Energieunternehmen verlor 243.000 Dollar, als Kriminelle die Stimme des CEOs eines Mutterkonzerns fälschten und eine Überweisung anordneten. Der Anruf klang so authentisch, dass der Mitarbeiter keinen Verdacht schöpfte – erst später wurde die Manipulation entdeckt (The Guardian). Dieser Fall war einer der ersten dokumentierten Einsätze von Voice-Cloning in der Wirtschaftskriminalität und zeigte die Verwundbarkeit von Unternehmen. - Deepfake-Pornografie-Skandal (2018):

Der Aufstieg von Deepfake-Pornos begann mit Plattformen wie Reddit, wo Nutzer Gesichter von Prominenten wie Scarlett Johansson auf pornografische Inhalte setzten. Nach öffentlichem Druck wurden solche Foren geschlossen, doch die Technologie verbreitete sich weiter. Opfer berichten von Scham, Angst und beruflichen Konsequenzen, während Täter oft ungestraft bleiben (Wired über Deepfake-Pornos). - Bankbetrug mit Deepfake-Videos (2021):

In den USA nutzten Kriminelle ein gefälschtes Video, um eine Gesichtserkennung bei einer Online-Bank zu umgehen und Konten zu plündern. Die Täter hatten Fotos des Opfers aus sozialen Medien gesammelt und mit DeepFaceLab ein Video erstellt (Forbes über Bankbetrug). Dieser Fall verdeutlicht, wie alltägliche Technologien für schwere Verbrechen genutzt werden können. - Erpressung in Indien (2023):

Eine Frau erhielt ein Deepfake-Video, das sie in einer kompromittierenden Situation zeigte, obwohl sie nie gefilmt wurde. Die Täter forderten 50.000 Rupien, um das Video nicht zu veröffentlichen. Die Polizei konnte die Quelle nicht eindeutig zurückverfolgen, was die internationale Dimension des Problems zeigt (The Times of India).

Technische Grundlagen: Wie Kriminelle vorgehen

Die Erstellung krimineller Deepfakes folgt einem klaren Muster:

- Datensammlung: Bilder und Videos von Opfern werden aus sozialen Medien wie Instagram oder LinkedIn extrahiert. Für Stimmen reichen oft kurze Audioaufnahmen, etwa von Voicemails.

- Training: KI-Modelle werden mit Tools wie DeepFaceLab oder ElevenLabs trainiert, oft auf Cloud-Plattformen wie AWS oder Google Colab.

- Manipulation: Gesichter werden auf Videos übertragen oder Stimmen synthetisiert, gefolgt von Nachbearbeitung mit Adobe Audition für Audio oder Premiere für Video.

- Verbreitung: Anonyme Plattformen wie Tor oder verschlüsselte Messenger wie Telegram dienen zur Verbreitung oder Kontaktaufnahme mit Opfern.

Die Demokratisierung dieser Technologien bedeutet, dass selbst Kleinkriminelle mit minimalem technischen Wissen Deepfakes erstellen können – eine Entwicklung, die die Kriminalitätsrate in diesem Bereich in die Höhe treibt.

Teil 2: Risiken und Herausforderungen

Finanzielle Verluste: Ein Milliardenproblem

Deepfake-Betrug verursacht enorme wirtschaftliche Schäden. Laut Cybersecurity Ventures könnten Cyberkriminalität, einschließlich Deepfakes, bis 2025 jährlich 10,5 Billionen Dollar kosten. Unternehmen sind besonders anfällig: Ein einziger CEO-Betrug kann Millionen kosten, während kleinere Firmen durch wiederholte Angriffe in den Ruin getrieben werden. Privatpersonen verlieren durch Identitätsdiebstahl oder Erpressung oft ihre Ersparnisse, ohne Aussicht auf Rückerstattung.

Die Geschwindigkeit und Skalierbarkeit von Deepfakes verschärfen das Problem. Während traditioneller Betrug persönlichen Kontakt oder aufwendige Vorbereitung erforderte, können Deepfakes massenhaft und automatisiert eingesetzt werden – etwa durch Bots, die gefälschte Anrufe an Hunderte Ziele gleichzeitig starten.

Strafverfolgung: Ein Katz-und-Maus-Spiel

Die Verfolgung von Deepfake-Kriminellen ist ein Albtraum für Behörden:

- Anonymität: Täter nutzen VPNs, Tor oder Kryptowährungen wie Bitcoin, um unerkannt zu bleiben (Europol IOCTA 2021).

- Grenzüberschreitend: Ein Betrüger in Russland kann ein Opfer in Deutschland angreifen, was die Zuständigkeit kompliziert. Internationale Kooperation ist oft langsam und bürokratisch.

- Beweisprobleme: Deepfakes sind schwer nachzuweisen, da Metadaten manipuliert oder gelöscht werden können. Forensische Analysen erfordern teure Technologien und Experten, die nicht überall verfügbar sind (FBI über Cybercrime).

Psychologische Schäden: Unsichtbare Wunden

Opfer von Deepfake-Kriminalität leiden oft unter schwerwiegenden emotionalen Folgen:

- Erpressung: Personen, die mit gefälschten pornografischen Videos konfrontiert werden, berichten von Scham, Angst und Depressionen. Manche ziehen sich aus dem öffentlichen Leben zurück oder verlieren Jobs (Psychology Today).

- Vertrauensverlust: Opfer von Identitätsdiebstahl kämpfen oft jahrelang, um ihre Reputation wiederherzustellen. Familienmitglieder oder Freunde könnten gefälschten Anrufen misstrauen, was Beziehungen belastet.

- Trauma: Die Unsicherheit, ob ein Video veröffentlicht wird, kann zu posttraumatischen Belastungsstörungen führen, besonders wenn Kinder oder Partner involviert sind.

Gesellschaftliche Auswirkungen

Deepfakes könnten das Vertrauen in digitale Systeme – etwa Online-Banking oder Telefongespräche – untergraben. Wenn niemand mehr sicher ist, ob eine Stimme echt ist, könnten Menschen auf analoge Kommunikation zurückgreifen, was die Digitalisierung bremst. In Entwicklungsländern, wo technische Schutzmaßnahmen fehlen, könnten Deepfakes besonders verheerend wirken.

Teil 3: Schutzmaßnahmen und Hilfestellungen

Technologische Lösungen: Abwehr mit KI und Blockchain

Technologie ist der Schlüssel, um Deepfake-Kriminalität zu bekämpfen:

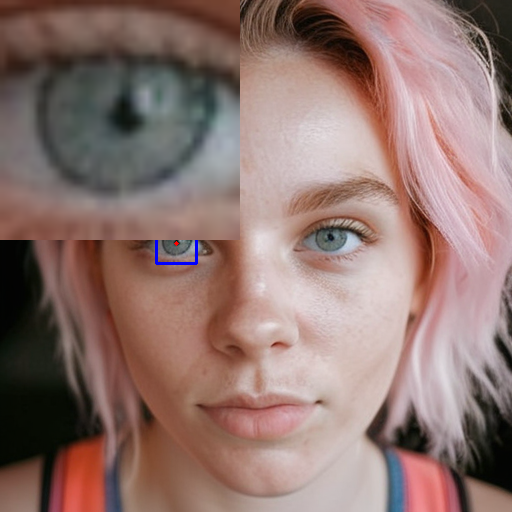

- DNID Deepfake Scanner:

https://dnid.me/ ist ein potenzieller Deepfake-Scanner für Videos, der speziell darauf ausgelegt ist, Manipulationen zu erkennen – von unnatürlichen Bewegungen über Lippen-Synchronisationsfehler bis hin zu Hauttexturen. Dieses Tool ist ideal, um gefälschte Videoanrufe, Erpressungsmaterial oder Identitätsdiebstahl-Videos zu prüfen. Ladet einfach das Video hoch, und DNID liefert eine Analyse – perfekt für Unternehmen, die Anrufe verifizieren, oder Privatpersonen, die sich vor Erpressung schützen wollen. Seine Benutzerfreundlichkeit und der Fokus auf Videos machen es zu einem unverzichtbaren Helfer im Kampf gegen Cybercrime. - Deepware Scanner:

Ein Open-Source-Tool, das Deepfakes anhand von visuellen und strukturellen Anomalien identifiziert. Es ist kostenlos und für technisch versierte Nutzer geeignet (Deepware). Ihr könnt es lokal installieren und verdächtige Dateien prüfen – etwa ein Video, das euch per E-Mail erreicht. - Truepic:

Dieses Tool nutzt Blockchain, um die Echtheit von Videos zu verifizieren. Es fügt bei der Aufnahme eine digitale Signatur hinzu, die Manipulationen sichtbar macht (Truepic). Unternehmen könnten es nutzen, um offizielle Kommunikation abzusichern. - Voice Authentication:

Tools wie Pindrop analysieren Stimmen auf synthetische Artefakte und schützen vor Voice-Cloning. Sie werden bereits von Banken eingesetzt, um Anrufe zu verifizieren.

Praktische Hilfestellungen: Tipps zum Schutz

Hier sind ausführliche Tipps, um euch vor Deepfake-Kriminalität zu schützen:

- Verifizierungscodes einführen:

Legt mit Kollegen, Familienmitgliedern oder Geschäftspartnern geheime Codes fest – etwa ein Satz wie „Der Himmel ist heute blau“ –, den ihr bei verdächtigen Anrufen abfragt. Echte Personen kennen den Code, gefälschte Stimmen nicht. Dokumentiert diese Codes sicher, etwa in einem verschlüsselten Notizbuch wie LastPass. - Videoanalyse durchführen:

Nutzt VLC Media Player, um Videos frameweise zu prüfen:- Lippen-Synchronisation: Stimmen Worte und Lippen überein? Kleine Verzögerungen oder unnatürliche Bewegungen sind Warnsignale.

- Hauttexturen: Achtet auf Übergänge zwischen Gesicht und Hals – Uneinheitlichkeiten deuten auf Manipulation.

- Augenreflexionen: Unterschiedliche Lichtreflexionen in den Augen sind ein subtiler Hinweis. Dieser Prozess ist zeitaufwendig, aber effektiv, besonders bei Erpressungsvideos.

- Sicherheitssoftware installieren:

Tools wie Kaspersky, Norton oder Bitdefender erkennen Phishing-Versuche und warnen vor verdächtigen Dateien. Aktiviert Echtzeit-Scans, um Deepfake-Videos oder -Anrufe frühzeitig zu identifizieren. Für Unternehmen: Investiert in CrowdStrike, das speziell auf Cyberbedrohungen abzielt. - Verdächtiges melden:

Meldet Deepfake-Betrug bei der Polizei Onlinewache (Deutschland) oder dem FBI Internet Crime Complaint Center (international). Gebt so viele Details wie möglich an – Dateigröße, Quelle, Zeitpunkt –, um Ermittlungen zu unterstützen. In Deutschland könnt ihr auch BKA Cybercrime kontaktieren. - Datenschutz stärken:

Beschränkt eure öffentlichen Daten auf Plattformen wie Facebook oder Instagram. Setzt Profile auf privat, entfernt alte Fotos und überprüft regelmäßig eure digitalen Spuren mit Tools wie Have I Been Pwned. Weniger Daten bedeuten weniger Material für Deepfakes.

Unternehmensschutz

- Schulungen: Sensibilisiert Mitarbeiter für Deepfake-Betrug, etwa durch Simulationen von gefälschten Anrufen.

- Zwei-Faktor-Authentifizierung: Nutzt Duo Security oder Google Authenticator für finanzielle Transaktionen.

- Protokolle: Legt klare Verfahren für ungewöhnliche Anfragen fest – etwa eine zweite Bestätigung per E-Mail.

Teil 4: Zukunftsausblick

Echtzeit-Deepfakes

Die Zukunft der Deepfake-Kriminalität könnte Echtzeit-Manipulationen umfassen – etwa gefälschte Videoanrufe, bei denen Täter live mit Opfern sprechen (The Verge). Tools wie NVIDIA Maxine machen dies möglich, was Betrug noch schwerer erkennbar macht.

Forensische Gegenmaßnahmen

- KI-Forensik: Programme wie DARPA MediFor entwickeln Algorithmen, um Deepfakes in Echtzeit zu entlarven.

- Stimmverifikation: Fortschritte bei Pindrop könnten Voice-Cloning automatisch stoppen.

- Blockchain: Ein globales System für verifizierte Inhalte könnte Standard werden.

Gesellschaftliche Anpassung

Langfristig könnten wir uns an eine Welt gewöhnen, in der digitale Beweise misstraut wird. Dies könnte zu strengeren Identitätskontrollen führen – etwa biometrische Systeme mit zusätzlichen Sicherheitsstufen.

Schreibe einen Kommentar