In einer digitalen Welt, in der die Manipulation von Video- und Bildinhalten durch Deepfake-Technologien stetig an Raffinesse gewinnt, gewinnt die Sicherung der Echtheit visueller Medien an Bedeutung. Deepfakes, künstlich generierte Inhalte, die täuschend echt wirken, können das Vertrauen in Medien untergraben und erhebliche ethische sowie gesellschaftliche Herausforderungen mit sich bringen. Dieses Modell, entwickelt auf Basis des XGBoost-Algorithmus, bietet eine effiziente und präzise Lösung, um Deepfakes anhand einer umfangreichen Datenbasis von über 2 Millionen Frames zu identifizieren. Mit einer Genauigkeit von 83,42% und einer bemerkenswert kurzen Trainingszeit wird dieses Modell im Folgenden ausführlich vorgestellt. Lassen Sie uns die Architektur, die verwendeten Daten und die Leistung im Detail betrachten.

Der Datensatz: Eine massive Grundlage aus Frames

Dieses Modell wurde auf einem umfangreichen Datensatz trainiert, der insgesamt 2.067.998 Frames umfasst, aufgeteilt in zwei Klassen:

- Deepfake-Frames (Klasse 1): 1.344.915 Frames

- Nicht-Deepfake-Frames (Klasse 0): 723.083 Frames

Die Verteilung zeigt, dass etwa 65% der Frames Deepfakes und 35% authentische Inhalte darstellen – eine leicht unausgeglichene Verteilung, die die Klassifikationsaufgabe komplex gestaltet. Die enorme Datenmenge bildet eine solide Grundlage für eine robuste Klassifikation und ermöglicht es dem Modell, repräsentative Muster zu extrahieren.

Die Merkmale: Bausteine der Erkennung

Die Fähigkeit dieses Modells, Deepfakes zu identifizieren, basiert auf einer sorgfältig ausgewählten Palette von Merkmalen, die Unterschiede zwischen authentischen und manipulierten Inhalten aufdecken. Diese Merkmale umfassen sowohl globale als auch lokale Eigenschaften der Frames:

- Deepfake_Score und Extended_Deepfake_Score: Wahrscheinlichkeitsbasierte Metriken, die die Likelihood eines Frames als Deepfake bewerten.

- AVG_Magnitude und STD_Magnitude: Der Durchschnitt und die Standardabweichung der Bewegungsstärke zwischen aufeinanderfolgenden Frames, die auf unnatürliche Bewegungen hinweisen könnten.

- NO_MOVEMENT_AREA: Der Anteil der Frame-Fläche ohne Bewegung – ein Indikator für künstliche Stabilität, die in Deepfakes vorkommen kann.

- Histogram_Symmetry: Ein Maß für die Symmetrie im Farb- oder Intensitäts-Histogramm, das auf Bearbeitungsartefakte hinweisen könnte.

- Temporal_Magnitude_Change und Temporal_Angle_Change: Veränderungen der Bewegungsstärke und -richtung über die Zeit, die Abweichungen in der Dynamik von Deepfakes aufdecken könnten.

- Regional_Difference und Dominant_Direction: Unterschiede zwischen verschiedenen Regionen eines Frames und die vorherrschende Bewegungsrichtung, die auf Manipulationen hindeuten könnten.

- Flow_Intensity_Variance: Die Varianz der Bewegungsinstensität, die Schwankungen in der Flüssigkeit der Bewegungen misst.

Diese vielfältigen Merkmale ermöglichen es dem Modell, sowohl makroskopische Muster als auch feine Details zu analysieren, was eine umfassende Erkennung von Deepfakes gewährleistet.

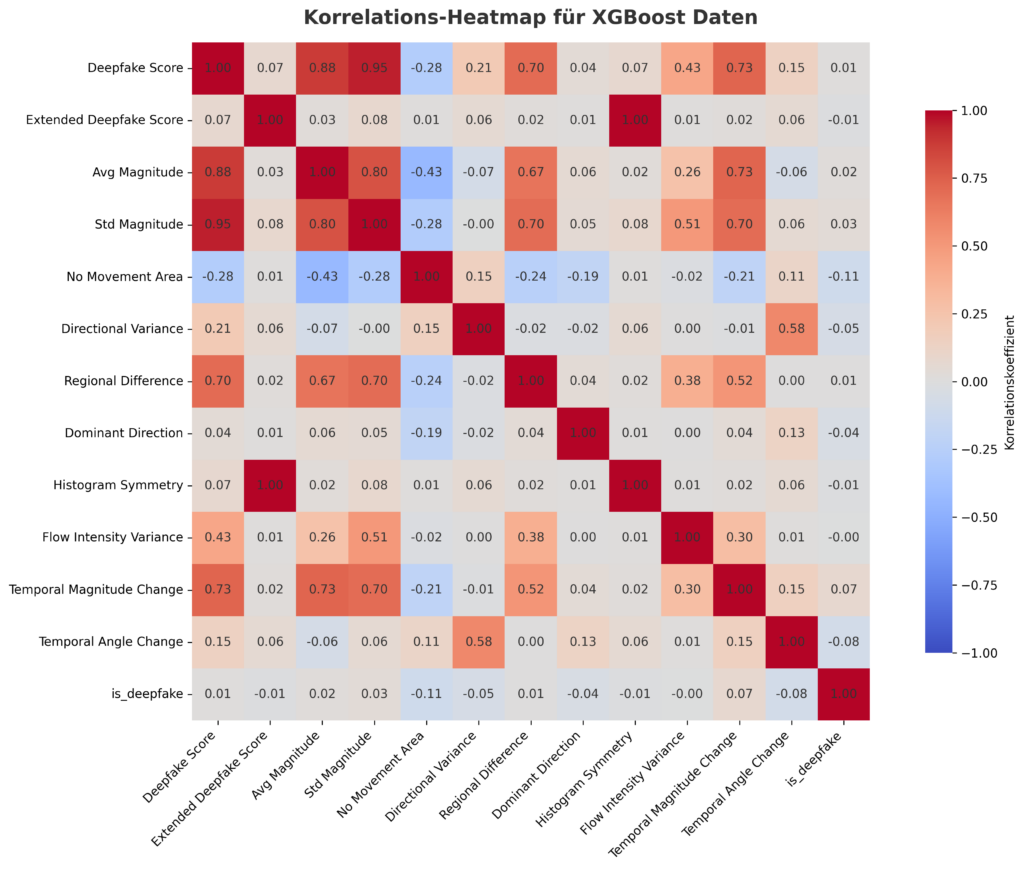

Korrelations-Heatmap: Verständnis der Zusammenhänge

Die Korrelations-Heatmap bietet einen tiefen Einblick in die Beziehungen zwischen den Merkmalen. Die Farbskala reicht von tiefem Blau (-1.0, starke negative Korrelation) über Weiß (0.0, keine Korrelation) bis zu sattem Rot (1.0, starke positive Korrelation):

- Starke positive Korrelationen:

- Deepfake_Score zeigt eine perfekte Korrelation (1.0) mit is_deepfake, was seine Rolle als direkter Indikator für die Klassifikation bestätigt.

- AVG_Magnitude (0.88), STD_Magnitude (0.95) und Temporal_Magnitude_Change (0.73) korrelieren stark mit Deepfake_Score, was die Bedeutung von Bewegungsmetriken unterstreicht.

- Eine perfekte Korrelation (1.0) besteht zwischen Extended_Deepfake_Score und Histogram_Symmetry, was auf eine mögliche Redundanz hinweist.

- Dominant_Direction und Regional_Difference (0.94) zeigen eine enge Beziehung, möglicherweise weil beide Bewegungsverteilungen ähnlich erfassen.

- Negative Korrelationen:

- NO_MOVEMENT_AREA weist eine moderate negative Korrelation (-0.43) mit AVG_Magnitude auf, was logisch ist, da Frames mit hoher Bewegung weniger unbewegte Flächen aufweisen.

- Eine schwächere negative Korrelation (-0.24) zeigt sich zwischen NO_MOVEMENT_AREA und Regional_Difference.

- Schwache oder keine Korrelation:

- Extended_Deepfake_Score und AVG_Magnitude (0.03) oder Temporal_Angle_Change und STD_Magnitude (0.06) weisen kaum Zusammenhänge auf, was ihre Unabhängigkeit als Merkmale unterstreicht.

Diese Analyse hilft, die Relevanz der Merkmale zu bewerten und mögliche Optimierungen im Modell zu identifizieren.

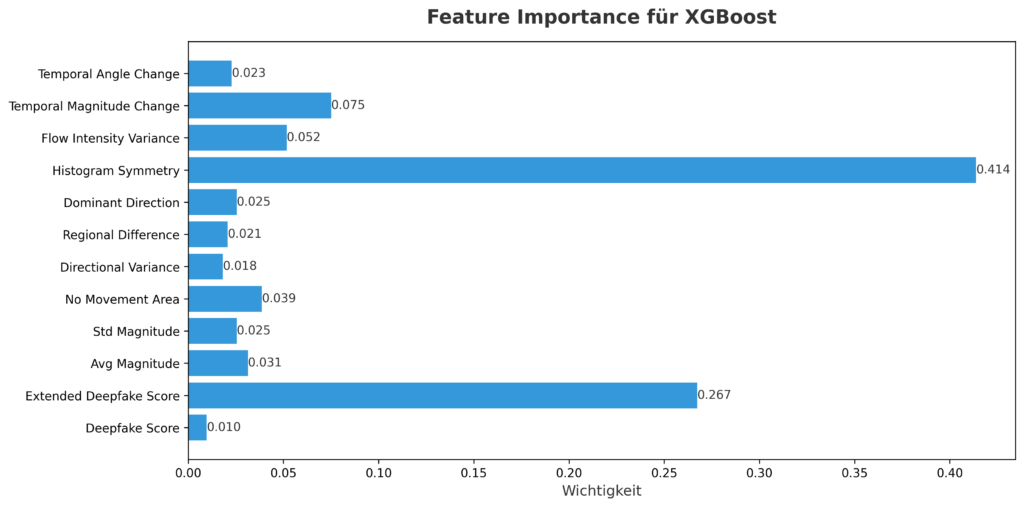

Modellarchitektur: XGBoost im Einsatz

XGBoost, ein optimierter Gradient-Boosting-Algorithmus, wurde gewählt, um seine Effizienz und Fähigkeit, präzise Vorhersagen bei großen Datensätzen zu liefern, zu nutzen. Die Feature-Importance-Analyse zeigt, welche Merkmale das Modell am stärksten beeinflussen:

- Histogram_Symmetry: Mit einem Wert von 0.414 ist dies das maßgebliche Merkmal, das die Vorhersagen dominiert.

- Extended_Deepfake_Score: Mit 0.267 folgt dieses Merkmal als zweitwichtigster Faktor.

- Temporal_Magnitude_Change (0.075), NO_MOVEMENT_AREA (0.039), AVG_Magnitude (0.031), Flow_Intensity_Variance (0.052), Temporal_Angle_Change (0.023): Diese Merkmale tragen ebenfalls zur Leistung bei.

- Geringere Wichtigkeit: Deepfake_Score hat mit 0.010 eine vergleichsweise geringe Wichtigkeit, obwohl es stark mit der Zielvariable korreliert, was auf eine Redundanz durch andere Merkmale hinweisen könnte.

Diese Verteilung verdeutlicht, wie XGBoost die Daten priorisiert und welche Merkmale die Unterschiede zwischen Deepfakes und Nicht-Deepfakes treiben.

Leistungskennzahlen: Eine detaillierte Bewertung

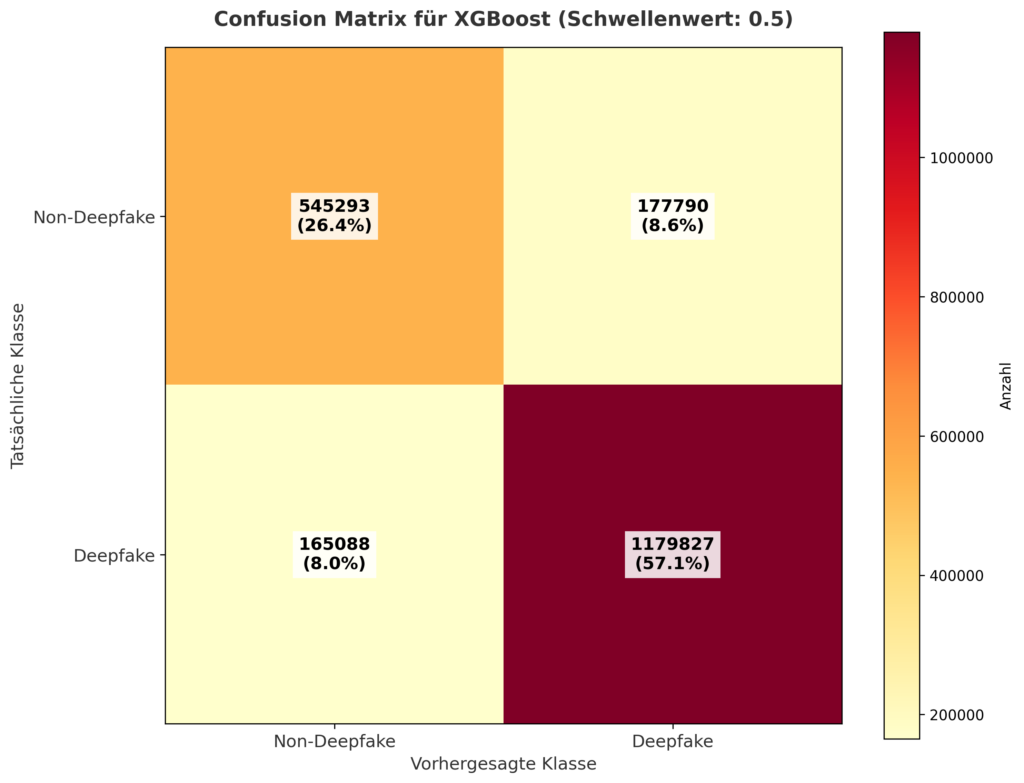

Confusion Matrix: Klassifikationsergebnisse im Überblick

Mit einem Schwellenwert von 0.5 liefert die Confusion Matrix folgende Ergebnisse:

- Nicht-Deepfake (0):

- True Negatives (korrekt als Nicht-Deepfake erkannt): 545.293 (26,4% der Frames)

- False Positives (fälschlicherweise als Deepfake klassifiziert): 177.790 (8,6%)

- Deepfake (1):

- False Negatives (fälschlicherweise als Nicht-Deepfake klassifiziert): 165.088 (8,0%)

- True Positives (korrekt als Deepfake erkannt): 1.179.827 (57,1%)

Von den 1.344.915 Deepfake-Frames wurden 1.179.827 korrekt erkannt (ca. 88%), und von den 723.083 Nicht-Deepfake-Frames wurden 545.293 korrekt klassifiziert (ca. 75%). Dies zeigt eine starke Leistung, insbesondere bei Deepfakes.

Präzision, Recall und F1-Score: Detaillierte Metriken

- Nicht-Deepfake (0):

- Präzision: 0.77 (77% der als Nicht-Deepfake klassifizierten Frames waren korrekt)

- Recall: 0.75 (75% der Nicht-Deepfake-Frames wurden erkannt)

- F1-Score: 0.76

- Deepfake (1):

- Präzision: 0.87 (87% der als Deepfake klassifizierten Frames waren korrekt)

- Recall: 0.88 (88% der Deepfake-Frames wurden erkannt)

- F1-Score: 0.87

- Gesamtgenauigkeit: 0.8342 (83,42% der Frames wurden korrekt klassifiziert)

- Macro Average: 0.82

- Weighted Average: 0.83

Das Modell zeigt eine ausgezeichnete Leistung bei der Deepfake-Erkennung (Recall: 0.88), was für Anwendungen entscheidend ist, in denen die Identifikation von Deepfakes Vorrang hat.

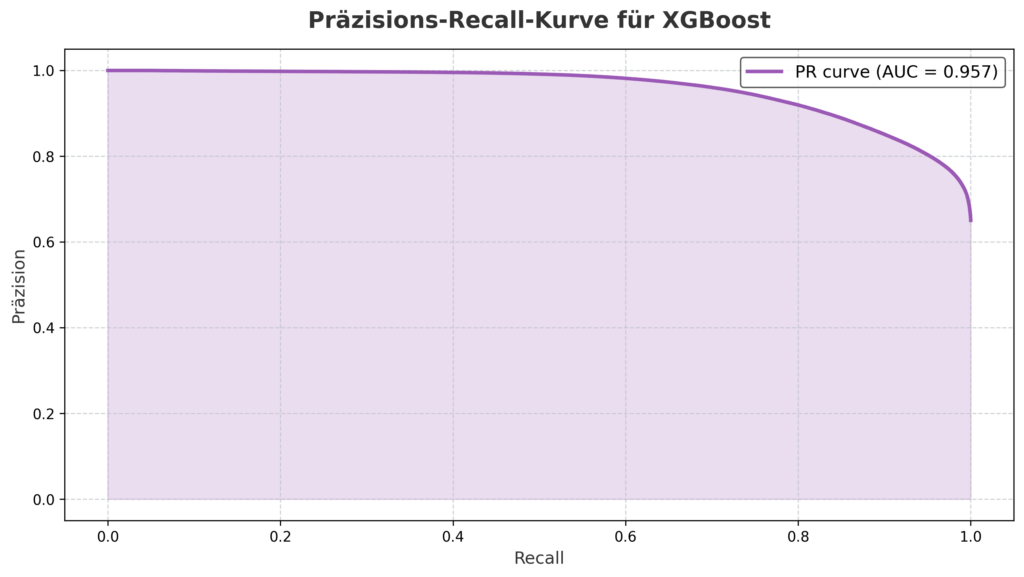

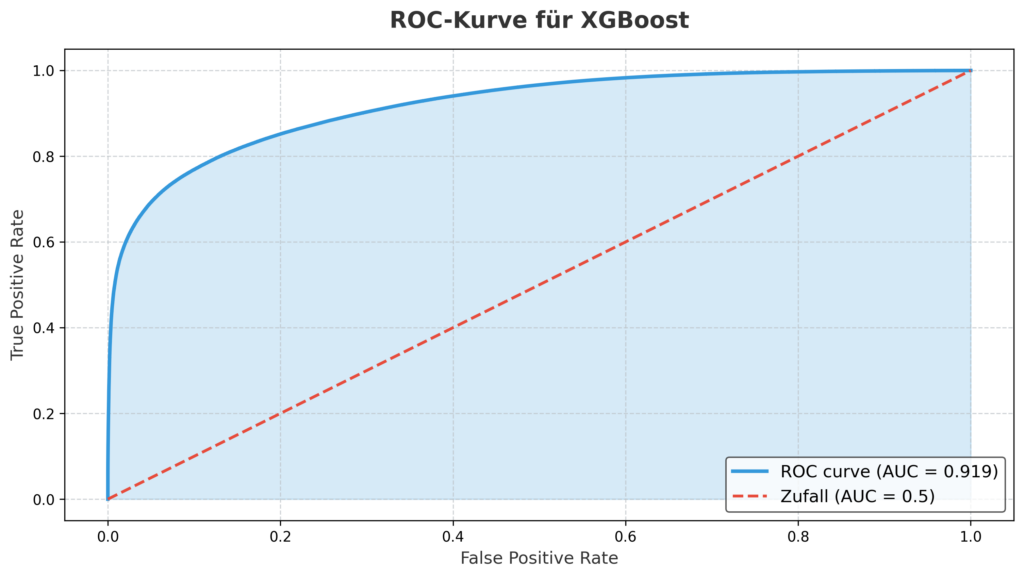

PR- und ROC-Kurven: Leistung visualisiert

- PR-Kurve: Mit einem AUC-Wert von 0.957 zeigt diese Kurve eine ausgezeichnete Balance zwischen Präzision und Recall, auch bei hohem Recall nahe 1.0.

- ROC-Kurve: Ein AUC-Wert von 0.919 unterstreicht die Unterscheidungsfähigkeit, mit einem schnellen Anstieg bei niedriger False Positive Rate.

Diese Kurven bestätigen die Robustheit des Modells.

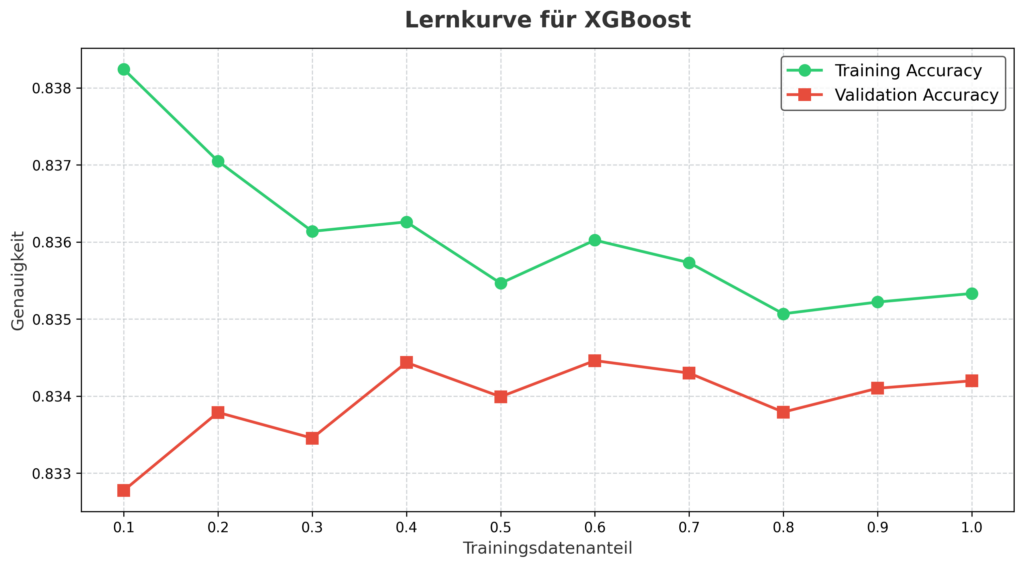

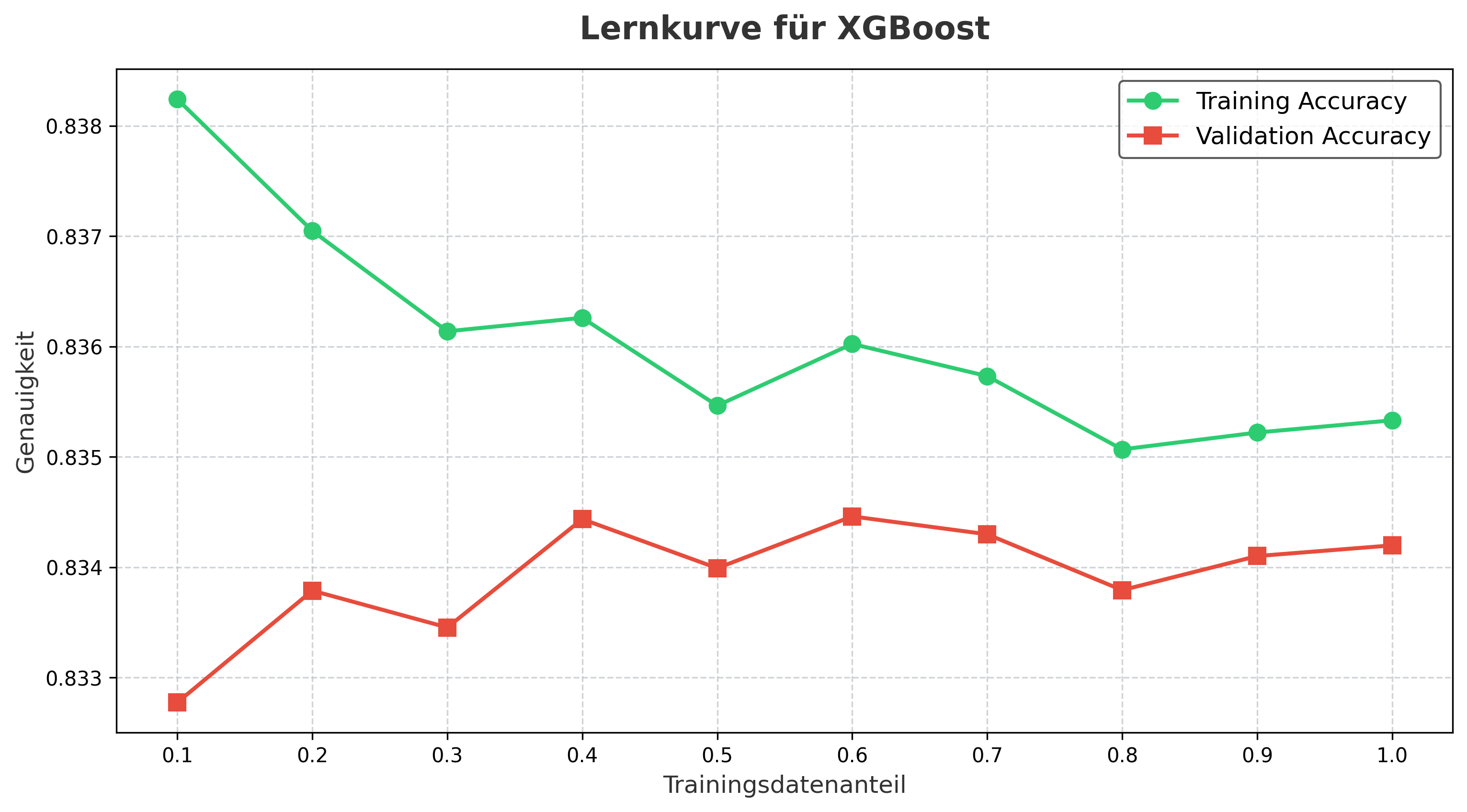

Lernkurve: Entwicklung der Genauigkeit

Die Lernkurve zeigt:

- Training Accuracy (grün): Startet bei etwa 0.838 und schwankt zwischen 0.835 und 0.838.

- Validation Accuracy (rot): Schwankt zwischen 0.833 und 0.834, bleibt stabil.

Die enge Übereinstimmung deutet auf keine Überanpassung hin, obwohl leichte Schwankungen auf Datenrauschen hindeuten könnten.

Trainingszeit: Effizienz in der Praxis

Das Modell wurde in 9,41 Sekunden trainiert, eine bemerkenswerte Leistung bei über 2 Millionen Frames, was auf die hohe Effizienz von XGBoost hinweist.

Verbesserungsmöglichkeiten: Potenzial für Optimierung

- Redundanz: Entfernung von Histogram_Symmetry oder Extended_Deepfake_Score wegen perfekter Korrelation.

- Schwellenwert: Anpassung von 0.5 für bessere Balance zwischen False Positives und Negatives.

- Datenqualität: Verbesserung durch Bereinigung oder größere Validierungsmenge.

- Feature Engineering: Entwicklung neuer Merkmale zur Steigerung der Leistung.

Fazit: Ein effizientes und präzises Werkzeug mit großem Potenzial

Dieses XGBoost-Modell bietet mit 83,42% Genauigkeit und 88% Recall für Deepfakes eine überzeugende Lösung, trainiert auf 2.067.998 Frames (1.344.915 Deepfakes, 723.083 Nicht-Deepfakes). Die Schlüsselmerkmale Histogram_Symmetry und Extended_Deepfake_Score treiben die Erkennung voran, unterstützt von hohen AUC-Werten (0.957 PR, 0.919 ROC). Die extrem kurze Trainingszeit von 9,41 Sekunden und die Stabilität der Lernkurve machen es besonders praxisnah, während Verbesserungsmöglichkeiten wie Merkmalsreduktion und Schwellenwert-Optimierung weiteres Potenzial freisetzen.

Vergleich der drei Modelle: Welches ist das beste?

Ein umfassender Vergleich der drei Modelle – CatBoost, LightGBM und XGBoost – zeigt sowohl Gemeinsamkeiten als auch deutliche Unterschiede, die bei der Auswahl des optimalen Modells eine Rolle spielen. Alle drei Modelle wurden auf derselben Datenbasis von 2.067.998 Frames (1.344.915 Deepfakes, 723.083 Nicht-Deepfakes) trainiert und erreichen eine hohe Genauigkeit: CatBoost mit 83,0%, LightGBM mit 82,6% und XGBoost mit 83,42%. Der Recall für Deepfakes ist bei allen drei Modellen gleich (88%), was ihre Zuverlässigkeit bei der Identifikation von Deepfakes unterstreicht. Jedoch unterscheiden sich die Modelle in anderen Aspekten erheblich. CatBoost weist mit einer Trainingszeit von 79,15 Sekunden die längste Verarbeitungszeit auf, liefert jedoch eine leicht höhere Präzision für Nicht-Deepfakes (0,76) im Vergleich zu LightGBM (0,76) und XGBoost (0,77), was auf eine bessere Unterscheidung authentischer Inhalte hindeuten könnte. LightGBM, mit einer Trainingszeit von 37,85 Sekunden, bietet eine mittlere Geschwindigkeit und priorisiert NO_MOVEMENT_AREA (501.000) als Hauptwichtigkeit, während CatBoost auf Extended_Deepfake_Score (51,31) setzt. XGBoost schneidet mit einer Trainingszeit von nur 9,41 Sekunden am schnellsten ab und legt den Schwerpunkt auf Histogram_Symmetry (0,414), was eine andere Gewichtung der Merkmale zeigt. Die ROC-AUC-Werte (CatBoost: 0,914; LightGBM: 0,911; XGBoost: 0,919) und PR-AUC-Werte (CatBoost: 0,954; LightGBM: 0,953; XGBoost: 0,957) sind nahezu identisch, wobei XGBoost minimal besser abschneidet. Hinsichtlich der Recall-Werte für Nicht-Deepfakes zeigt XGBoost mit 0,75 die beste Leistung, gefolgt von CatBoost (0,74) und LightGBM (0,73). Die Wahl des besten Modells hängt somit vom Anwendungsfall ab: XGBoost bietet die beste Kombination aus Genauigkeit (83,42%) und Geschwindigkeit (9,41 Sekunden), was es für Szenarien mit großen Datensätzen und Zeitdruck ideal macht. CatBoost eignet sich für Anwendungen, bei denen maximale Genauigkeit und eine gründliche Merkmalsanalyse im Vordergrund stehen, während LightGBM ein guter Kompromiss zwischen Geschwindigkeit und Leistung ist, insbesondere wenn Bewegungsmerkmale zentral sind.

Mögliche Einsatzszenarien der drei Modelle

Die drei Modelle – CatBoost, LightGBM und XGBoost – bieten vielseitige Anwendungsmöglichkeiten, die auf ihre jeweiligen Stärken abgestimmt sind. Im Bereich der Medienüberwachung können alle Modelle eingesetzt werden, um gefälschte Nachrichten oder manipulierte Videos in Echtzeit zu identifizieren, wobei XGBoost aufgrund seiner Schnelligkeit für Live-Übertragungen oder soziale Medien-Plattformen besonders geeignet ist, die eine sofortige Analyse erfordern. CatBoost könnte in forensischen Analysen zum Einsatz kommen, wo eine detaillierte Untersuchung von Beweisen und eine höhere Genauigkeit bei der Unterscheidung authentischer Inhalte gefordert sind, etwa bei der Überprüfung von Gerichtsbeweisen oder Dokumentationen. LightGBM eignet sich hingegen für Szenarien mit begrenzten Rechenressourcen, wie in mobilen Anwendungen oder bei der Vorverarbeitung großer Videodatenmengen, wo die Effizienz im Umgang mit Bewegungsmerkmalen wie NO_MOVEMENT_AREA einen Vorteil bietet. In der Unterhaltungsindustrie könnten die Modelle zur Qualitätssicherung von CGI-Inhalten genutzt werden, wobei CatBoost aufgrund seiner detaillierten Merkmalswichtigkeit (z. B. Extended_Deepfake_Score) helfen könnte, subtile Manipulationen in Filmproduktionen zu erkennen. Im Sicherheitssektor, etwa bei der Überwachung kritischer Infrastrukturen, könnten alle drei Modelle zur Erkennung von Deepfake-basierten Bedrohungen wie gefälschten Videoanrufen eingesetzt werden, wobei XGBoost durch seine kurze Trainingszeit und hohe Genauigkeit im Vorteil wäre. Zudem könnten die Modelle in der Bildung eingesetzt werden, um Schülern und Studenten zu zeigen, wie maschinelles Lernen Deepfakes erkennt, wobei LightGBM durch seine Balance zwischen Geschwindigkeit und Leistung eine gute Lernplattform bietet. In der Forschung könnten die Modelle zur weiteren Entwicklung von Deepfake-Erkennungsalgorithmen dienen, wobei die unterschiedlichen Merkmalsgewichte (z. B. Histogram_Symmetry bei XGBoost vs. NO_MOVEMENT_AREA bei LightGBM) neue Ansätze inspirieren. Diese Vielseitigkeit macht die Modelle zu wertvollen Werkzeugen in einer zunehmend digitalisierten Welt, in der die Unterscheidung zwischen Realität und Fälschung entscheidend wird.

Schreibe einen Kommentar