Einführung: Deepfakes als politische Waffe

Deepfakes – realistische, durch künstliche Intelligenz (KI) generierte Medien, die Personen in gefälschten Szenen oder Aussagen darstellen – haben das Potenzial, die politische Landschaft grundlegend zu verändern. In einer Welt, in der Videos und Audiodateien oft als unumstößliche Beweise für Wahrheit gelten, können Deepfakes Wahlen manipulieren, öffentliche Meinungen verzerren und das Vertrauen in demokratische Institutionen nachhaltig erschüttern. Die Technologie, die einst als futuristische Spielerei begann, ist heute eine ernstzunehmende Bedrohung – aber auch eine Chance, unsere Medienkompetenz und Schutzmechanismen zu stärken.

Teil 1: Der Einsatz von Deepfakes in der Politik

Historischer Kontext: Von analogen Fälschungen zu KI

Die Idee, Medien für politische Zwecke zu manipulieren, ist so alt wie die Politik selbst. Bereits im 19. Jahrhundert wurden Fotografien retuschiert, um politische Gegner in schlechtem Licht darzustellen – etwa Abraham Lincoln mit einem unvorteilhaften Gesichtsausdruck. Während des Kalten Krieges setzten Sowjetunion und USA bearbeitete Bilder und Filme ein, um Propaganda zu verbreiten. Doch mit dem Aufkommen von Deepfakes seit etwa 2017 hat sich die Qualität und Zugänglichkeit dieser Manipulationen dramatisch verändert. Basierend auf Deep Learning, insbesondere Generative Adversarial Networks (GANs) und Autoencodern, können heute selbst Laien mit begrenzten Ressourcen Videos erstellen, die täuschend echt wirken.

GANs, entwickelt von Ian Goodfellow im Jahr 2014, bestehen aus zwei Netzwerken: einem Generator, der gefälschte Inhalte produziert, und einem Diskriminator, der diese auf Echtheit prüft. Dieser Wettbewerb führt zu Ergebnissen, die oft kaum von echten Aufnahmen zu unterscheiden sind (MIT Technology Review über GANs). Autoencoder hingegen komprimieren Daten – etwa Gesichtszüge – und rekonstruieren sie, um Gesichter nahtlos auf andere Videos zu übertragen (Towards Data Science über Autoencoder). Diese Technologien haben die Schwelle für politische Manipulation drastisch gesenkt: Was früher Teams von Experten und Wochen an Arbeit erforderte, ist heute mit Tools wie DeepFaceLab in wenigen Stunden möglich.

Bekannte Beispiele: Deepfakes in Aktion

Die politische Welt hat bereits mehrere prominente Fälle von Deepfakes erlebt, die sowohl als Warnung als auch als Beweis für die Macht dieser Technologie dienen:

- Obama-Deepfake (2018):

Im April 2018 veröffentlichten der Komiker Jordan Peele und BuzzFeed ein Video, in dem Barack Obama scheinbar Donald Trump als „totalen und kompletten Idioten“ bezeichnet (BuzzFeed Video). Das Video war als satirische Demonstration gedacht, um die Öffentlichkeit auf die Gefahren von Deepfakes aufmerksam zu machen. Es wurde millionenfach angesehen und zeigte, wie überzeugend solche Fälschungen sein können. Peele nutzte eine Kombination aus KI und seiner eigenen Stimme, um Obama’s Tonfall und Lippenbewegungen zu imitieren – ein Prozess, der damals noch relativ aufwendig war, heute aber mit Tools wie Adobe After Effects und Descript einfacher ist. Dieser Fall war ein Weckruf für Politiker und Medien gleichermaßen. - Nancy Pelosi-Video (2019):

Im Mai 2019 tauchte ein manipuliertes Video von Nancy Pelosi, der Sprecherin des US-Repräsentantenhauses, auf. Darin schien sie lallend und verwirrt zu sprechen, was ihre Kompetenz infrage stellte. Das Video war kein „echter“ Deepfake, sondern eine verlangsamte Aufnahme mit veränderter Tonhöhe – eine einfachere Form der Manipulation, die dennoch millionenfach auf Plattformen wie Facebook und X geteilt wurde (Washington Post). Donald Trump selbst retweetete es, was die Reichweite weiter steigerte. Dieser Fall zeigte, dass selbst rudimentäre Manipulationen politischen Schaden anrichten können – ein Vorgeschmack auf die Macht fortschrittlicher Deepfakes. - Selenskyj-Deepfake (2022):

Während des Ukraine-Kriegs im März 2022 verbreitete sich ein gefälschtes Video von Präsident Wolodymyr Selenskyj, in dem er scheinbar seine Truppen zur Kapitulation auffordert (Reuters). Das Video war technisch nicht perfekt – etwa durch unnatürliche Lippenbewegungen erkennbar – wurde aber dennoch von prorussischen Kanälen genutzt, um Verwirrung zu stiften. Die ukrainische Regierung reagierte schnell mit einer Widerlegung, doch der Vorfall verdeutlichte, wie Deepfakes in Krisenzeiten als Waffe eingesetzt werden können. - Gabun-Wahl (2019):

Ein weniger bekannter, aber signifikanter Fall ereignete sich in Gabun. Ein Video von Präsident Ali Bongo, der nach einem Schlaganfall monatelang abwesend war, sollte die Bevölkerung beruhigen. Doch viele vermuteten ein Deepfake, was zu Unruhen und einem Putschversuch führte (The Atlantic). Ob es tatsächlich ein Deepfake war, blieb unklar, aber der Fall zeigt, wie allein der Verdacht politische Instabilität auslösen kann.

Politische Strategien: Wie Deepfakes eingesetzt werden

Deepfakes werden in der Politik gezielt für verschiedene Zwecke genutzt, die oft miteinander verknüpft sind:

- Wählerbeeinflussung:

Gefälschte Videos können kurz vor Wahlen veröffentlicht werden, um Skandale zu inszenieren oder Wähler zu verwirren. Ein Beispiel wäre ein Politiker, der scheinbar rassistische Äußerungen macht oder Korruption zugibt. Da Videos emotional stärker wirken als Texte, sind sie besonders effektiv (Pew Research über Medienvertrauen). Studien zeigen, dass 60 % der Menschen visuellen Inhalten mehr vertrauen als geschriebenen Berichten – ein Umstand, den Manipulatoren ausnutzen. - Desinformation und Propaganda:

Staaten wie Russland, China oder Nordkorea wurden verdächtigt, Deepfakes für hybride Kriegsführung einzusetzen. Ein gefälschtes Video eines NATO-Generals, der Truppenbewegungen ankündigt, könnte Panik auslösen oder Feindseligkeiten schüren. Laut Brookings Institution könnten solche Taktiken besonders in fragilen Demokratien wirksam sein, wo Medieninfrastrukturen schwach sind. - Vertrauen untergraben (Liar’s Dividend):

Der „Liar’s Dividend“ beschreibt ein Phänomen, bei dem echte Beweise als Deepfakes abgetan werden können, um Verantwortung zu vermeiden. Wenn ein Politiker in einem kompromittierenden Video auftaucht, könnte er behaupten, es sei gefälscht – selbst wenn es echt ist. Dieses Konzept wurde von Rechtswissenschaftlern wie Danielle Citron geprägt und zeigt, wie Deepfakes nicht nur durch Fälschung, sondern auch durch Zweifel Schaden anrichten (Wired über Liar’s Dividend). - Polarisierung:

Deepfakes können bestehende gesellschaftliche Spaltungen vertiefen, indem sie gezielt Gruppen ansprechen. Ein Video, das eine politische Figur in einer radikalen Aussage zeigt, könnte Anhänger mobilisieren oder Gegner provozieren, was die politische Landschaft weiter destabilisiert.

Technischer Prozess: Wie werden sie erstellt?

Politische Deepfakes erfordern Daten – oft öffentlich zugängliche Videos von Reden oder Interviews. Diese werden gesammelt, etwa über Plattformen wie YouTube oder C-SPAN. Anschließend wird ein Modell trainiert, das Gesichtszüge, Stimme und Bewegungen analysiert. Tools wie DeepFaceLab oder MyHeritage Deep Nostalgia machen dies möglich. Die Manipulation erfolgt durch Übertragung auf ein Zielvideo, gefolgt von Nachbearbeitung mit Software wie Adobe Premiere, um Fehler wie unnatürliche Beleuchtung oder Synchronisationsprobleme zu beheben. Dank Cloud-Diensten wie Google Colab ist dies auch für Amateure erschwinglich geworden.

Teil 2: Risiken und Herausforderungen

Wahlmanipulation: Timing ist alles

Einer der größten Risiken von Deepfakes in der Politik ist ihre Fähigkeit, Wahlen zu manipulieren. Ein Video, das wenige Tage vor einem Wahltag veröffentlicht wird – etwa ein Kandidat, der scheinbar Bestechung zugibt –, lässt wenig Zeit für Widerlegung oder Fact-Checking. Die emotionale Wirkung solcher Inhalte übertrumpft oft rationale Analysen. Laut einer Studie der University of Maryland könnten bis zu 20 % der unentschiedenen Wähler durch ein überzeugendes Deepfake beeinflusst werden. Dies ist besonders in Ländern mit knappen Wahlausgängen oder geringer Medienkompetenz gefährlich.

Beispiele wie die Pelosi-Manipulation zeigen, wie schnell sich solche Inhalte verbreiten. Selbst wenn sie später widerlegt werden, bleibt der Schaden bestehen – ein Phänomen, das Psychologen als „Anker-Effekt“ bezeichnen: Die erste Information, die Menschen erhalten, prägt ihre Meinung nachhaltig, selbst wenn sie korrigiert wird (Psychology Today über Anker-Effekt). In autoritären Staaten könnten Deepfakes sogar gezielt eingesetzt werden, um Oppositionelle zu diskreditieren oder Wahlergebnisse zu rechtfertigen.

Öffentliches Vertrauen: Der Verlust der Wahrheit

Deepfakes bedrohen das Vertrauen in audiovisuelle Medien, die lange als verlässliche Informationsquellen galten. Wenn jedes Video potenziell gefälscht sein könnte, wie können Bürger noch politische Ereignisse bewerten? Dies führt zu einer „postfaktischen“ Gesellschaft, in der Emotionen und Narrative Fakten überlagern. Laut The Guardian könnte dies langfristig zu politischer Apathie führen: Wenn nichts mehr glaubwürdig erscheint, ziehen sich Menschen aus dem öffentlichen Diskurs zurück.

Ein weiteres Problem ist die Verstärkung durch soziale Medien. Algorithmen auf Plattformen wie X oder Facebook priorisieren emotionale Inhalte, was Deepfakes eine virale Reichweite verschafft (MIT Technology Review über Algorithmen). In Ländern mit niedriger Medienkompetenz – etwa in Teilen Afrikas oder Südostasiens – könnten Deepfakes unkontrolliert kursieren, da Fact-Checking-Ressourcen fehlen.

Internationale Konflikte: Diplomatie unter Druck

Deepfakes könnten auch zwischenstaatliche Konflikte anheizen. Stellt euch ein Video vor, in dem ein Staatschef scheinbar einen militärischen Angriff ankündigt oder einen Verbündeten beleidigt. Solche Fälschungen könnten diplomatische Krisen auslösen, bevor die Wahrheit ans Licht kommt. Experten warnen vor einem „Deepfake Pearl Harbor“ – einem Ereignis, das durch Manipulation einen Krieg entfacht (Foreign Policy).

Ein hypothetisches Szenario: Ein gefälschtes Video zeigt den indischen Premierminister, wie er Pakistan bedroht. In einer Region mit ohnehin angespannten Beziehungen könnte dies militärische Mobilmachung auslösen. Selbst wenn die Fälschung entlarvt wird, bleibt das Misstrauen. Laut RAND Corporation könnten solche Taktiken von Staaten mit hybriden Kriegsstrategien wie Russland genutzt werden, um westliche Allianzen zu destabilisieren.

Rechtliche Grauzonen

Die rechtliche Verfolgung von Deepfakes in der Politik ist schwierig. Wer ist verantwortlich – der Ersteller, die Plattform oder der Verbreiter? Internationale Zuständigkeiten sind unklar, und die Anonymität im Netz erschwert Ermittlungen. In vielen Ländern fehlen spezifische Gesetze, was Täter schützt (UNESCO über KI-Ethik).

Teil 3: Gegenmaßnahmen und Hilfestellungen

Gesetzgebung: Nationale und internationale Ansätze

Regierungen weltweit reagieren unterschiedlich auf die Deepfake-Bedrohung:

- USA:

Kalifornien hat mit AB 730 ein Verbot von Deepfakes in Wahlkampagnen eingeführt, das 60 Tage vor Wahlen greift (California AB 730). Auf Bundesebene wird über den „DEEPFAKES Accountability Act“ diskutiert, der Kennzeichnungspflichten vorsieht (Congress.gov). Doch Kritiker bemängeln, dass die Gesetze zu eng gefasst sind und satirische Inhalte einschränken könnten. - EU:

Die Datenschutz-Grundverordnung (DSGVO) bietet Schutz vor unbefugter Nutzung persönlicher Daten, etwa für Deepfake-Training (EUR-Lex). Allerdings fehlen spezifische Deepfake-Regulierungen, was die EU-Kommission mit der „AI Act“-Initiative ändern will, die KI-Systeme nach Risiko klassifiziert (European Commission). - Deutschland:

Hier könnten bestehende Gesetze wie § 187 StGB (Verleumdung) oder Persönlichkeitsrechte angewendet werden (Bundesministerium der Justiz). Doch die Beweisführung ist schwierig, da technische Expertise und internationale Zusammenarbeit nötig sind. Die Bundesregierung fördert Projekte wie InVID, um Verifikationstools zu entwickeln. - Internationale Ebene:

Die UNESCO schlägt globale ethische Standards für KI vor, die Deepfakes einschließen (UNESCO). Doch die Umsetzung hängt von der Kooperation einzelner Staaten ab, was in einer geopolitisch gespaltenen Welt schwierig ist.

Technologische Lösungen: Erkennung und Prävention

Technologie ist ein zentraler Pfeiler im Kampf gegen Deepfakes. Hier sind einige der effektivsten Tools:

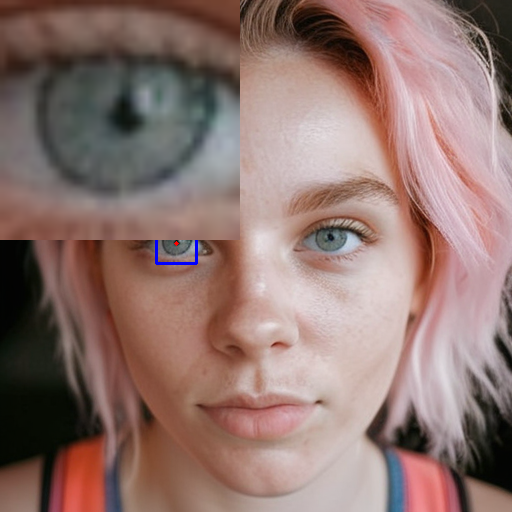

- DNID Deepfake Scanner:

Ein vielversprechendes Werkzeug ist https://dnid.me/, ein potenzieller Deepfake-Scanner mit Fokus auf Videos. DNID analysiert subtile Manipulationen wie unnatürliche Bewegungen, Lippen-Synchronisationsfehler, Hauttexturen oder Beleuchtungsanomalien. Es ist besonders nützlich für politische Videos, die auf Plattformen wie X, YouTube oder TikTok kursieren. Die Benutzerfreundlichkeit macht es ideal für Journalisten, Faktenchecker oder besorgte Bürger. Ladet einfach ein verdächtiges Video hoch und lasst DNID prüfen – ein unverzichtbares Tool, um schnell Klarheit zu schaffen. Probiert es aus, etwa bei einem Video eines Politikers, das euch seltsam vorkommt! - Microsoft Video Authenticator:

Dieses Tool nutzt KI, um Frame-für-Frame-Analysen durchzuführen und Anomalien wie unnatürliches Blinzeln oder Pixelartefakte zu erkennen (Microsoft). Es wurde in Zusammenarbeit mit Faktencheck-Organisationen entwickelt und ist besonders effektiv bei Social-Media-Inhalten. Die Software gibt eine Wahrscheinlichkeit an, ob ein Video manipuliert wurde – ein wertvoller Hinweis für politische Analysen. - Sensity AI:

Sensity konzentriert sich auf großflächige Deepfake-Erkennung und wird von Unternehmen und Regierungen genutzt, um Desinformationskampagnen zu bekämpfen (Sensity). Es kann nicht nur einzelne Videos prüfen, sondern auch Muster in Netzwerken erkennen – etwa wenn ein Deepfake gezielt über Bots verbreitet wird. - Blockchain-Verifikation:

Technologien wie Truepic oder Amber Authenticate nutzen Blockchain, um Videos mit digitalen Signaturen zu versehen. Diese Signaturen beweisen die Echtheit und Herkunft eines Videos, was in politischen Kontexten entscheidend sein könnte (CoinDesk über Blockchain). Regierungen könnten solche Systeme vorschreiben, um offizielle Verlautbarungen zu schützen.

Praktische Hilfestellungen: Was ihr tun könnt

Hier sind detaillierte Tipps, um Deepfakes in der Politik zu erkennen und euch zu schützen:

- Quellen überprüfen:

Prüft, woher ein Video stammt. Vertrauenswürdige Nachrichtenquellen wie tagesschau.de, BBC oder Reuters sind zuverlässiger als ein isolierter Post auf X. Wenn ein Video nur auf sozialen Medien kursiert, ohne Bestätigung von etablierten Medien, seid skeptisch. Nutzt Suchmaschinen, um die Herkunft zu verfolgen – etwa mit „site:.edu | site:.org | site:*.gov deepfake [Politikername]“ –, um glaubwürdige Berichte zu finden. - Zeitlupe nutzen:

Spielt verdächtige Videos mit VLC Media Player frameweise ab. Achtet auf:- Lippen-Synchronisation: Passen die Worte exakt zu den Lippenbewegungen? Kleine Verzögerungen oder Übertreibungen sind Hinweise.

- Bewegungen: Ruckeln Augen oder Wangen unnatürlich? Menschliche Bewegungen sind fließend, KI-generierte oft abgehackt.

- Beleuchtung: Stimmen Schatten und Reflexionen mit der Umgebung überein? Ein Gesicht, das heller wirkt als der Hintergrund, könnte eingefügt sein. Dieser Prozess erfordert Geduld, aber mit etwas Übung könnt ihr Manipulationen oft selbst entlarven.

- Metadaten analysieren:

Nutzt ExifTool, um Metadaten eines Videos auszulesen. Prüft Zeitstempel, Kamera-Details oder Bearbeitungsspuren. Wenn ein Video angeblich live aufgenommen wurde, aber Metadaten auf eine spätere Bearbeitung hinweisen (z. B. durch Software wie Premiere), ist das ein Warnsignal. Für Laien: Zieht Experten hinzu, etwa über Foren wie Stack Exchange. - Experten und Faktenchecker konsultieren:

Plattformen wie First Draft, Snopes oder Correctiv bieten professionelles Fact-Checking. Meldet verdächtige Videos dort oder sucht nach bestehenden Analysen. In Deutschland könnt ihr auch die Bundeszentrale für politische Bildung kontaktieren, die Ressourcen zur Medienanalyse bereitstellt. - Öffentlichkeit sensibilisieren:

Teilt eure Erkenntnisse mit Freunden oder auf Plattformen wie X, um andere zu warnen. Nutzt Hashtags wie #DeepfakeAwareness oder #Medienkompetenz, um Aufmerksamkeit zu erzeugen. Je mehr Menschen informiert sind, desto weniger wirksam sind solche Manipulationen.

Sensibilisierung der Bevölkerung

Neben individuellen Maßnahmen ist gesellschaftliche Aufklärung entscheidend:

- Schulprogramme: Medienkompetenz sollte im Unterricht verankert werden, etwa durch Analyse von Deepfake-Beispielen.

- Kampagnen: Öffentliche Spots wie „Fake News können jeden treffen“ der ARD könnten auf Deepfakes ausgeweitet werden (ARD Mediathek).

- Workshops: Lokale Initiativen in Bibliotheken oder Volkshochschulen könnten Bürger schulen, etwa mit praktischen Übungen zur Videoanalyse.

Teil 4: Zukunftsausblick

Echtzeit-Deepfakes

Die nächste Stufe der Bedrohung sind Echtzeit-Deepfakes, die während Live-Übertragungen manipuliert werden könnten – etwa eine gefälschte Rede bei einer TV-Debatte (The Verge). Technologien wie NVIDIA Maxine zeigen, wie realistisch dies bereits ist. Solche Entwicklungen könnten politische Diskurse in Echtzeit verzerren, ohne dass Zuschauer es sofort merken.

Gegenmaßnahmen der Zukunft

- KI-Detektoren: Fortschritte in der Erkennung, etwa durch DARPA’s MediFor, könnten Deepfakes automatisch identifizieren.

- Wasserzeichen: Digitale Signaturen oder unsichtbare Marker in Videos könnten Echtheit garantieren.

- Globale Kooperation: Ein internationales Abkommen zur Kennzeichnung von KI-Inhalten könnte den Missbrauch eindämmen.

Gesellschaftliche Anpassung

Langfristig müssen wir unsere Wahrnehmung von Medien neu kalibrieren. Vielleicht wird Skepsis zur Norm, und nur verifizierte Quellen gelten als glaubwürdig. Dies könnte jedoch auch die Kommunikation zwischen Regierungen und Bürgern erschweren.

Schreibe einen Kommentar