Einführung: Was sind Deepfakes?

Deepfakes – ein Begriff, der aus „Deep Learning“ und „Fake“ zusammengesetzt ist – bezeichnen hochrealistische, durch künstliche Intelligenz (KI) generierte Medien, meist Videos, Bilder oder Audiodateien, die Personen in Szenen zeigen oder Aussagen treffen lassen, die sie in Wirklichkeit nie gemacht haben. Diese Technologie hat sich in den letzten Jahren rasant entwickelt, angetrieben durch Fortschritte im maschinellen Lernen, leistungsstarke Hardware und die Verfügbarkeit von Open-Source-Software. Was einst als futuristische Vision in Science-Fiction-Filmen begann, ist heute Realität – und das mit tiefgreifenden Auswirkungen auf Unterhaltung, Gesellschaft, Politik und Ethik.

Von Hollywood-Produktionen, die verstorbene Schauspieler wieder zum Leben erwecken, über virale Social-Media-Clips, die Politiker in absurde Situationen versetzen, bis hin zu potenziell gefährlichen Desinformationskampagnen: Deepfakes sind allgegenwärtig. Doch wie funktionieren sie genau? Welche Möglichkeiten und Risiken bringen sie mit sich? Wie können wir sie erkennen – sowohl manuell als auch automatisiert? Und wie bereiten wir uns als Gesellschaft darauf vor? Dieser Blogbeitrag ist ein umfassender Rundumblick: Mit über 7.000 Wörtern, detaillierten Erklärungen, zahlreichen Links – einschließlich Dokumentationen – und praktischen Tipps bietet er alles, was ihr wissen müsst. Schnallt euch an – es wird eine lange Reise!

Teil 1: Die Technologie hinter Deepfakes

Künstliche Intelligenz und Deep Learning

Deepfakes basieren auf Deep Learning, einem Teilbereich der künstlichen Intelligenz, der neuronale Netzwerke nutzt, um komplexe Muster in riesigen Datenmengen zu erkennen. Zwei zentrale Technologien stehen im Fokus:

- Generative Adversarial Networks (GANs):

GANs bestehen aus zwei konkurrierenden Netzwerken: einem Generator, der gefälschte Inhalte wie Gesichter, Bewegungen oder Szenen erstellt, und einem Diskriminator, der diese Inhalte auf Echtheit überprüft. Der Generator versucht, den Diskriminator zu täuschen, während der Diskriminator immer besser darin wird, Fälschungen zu erkennen. Dieser Wettbewerb führt zu Ergebnissen, die oft verblüffend realistisch wirken. Die Technologie wurde 2014 von Ian Goodfellow entwickelt und hat seitdem die Welt der KI revolutioniert. Mehr bei MIT Technology Review. - Autoencoder:

Autoencoder sind neuronale Netzwerke, die Daten – etwa Gesichtszüge oder Bewegungen – in eine komprimierte Form (Latent Space) umwandeln und anschließend rekonstruieren. Bei Deepfakes wird ein Autoencoder trainiert, um das Gesicht einer Person A zu analysieren und auf das Gesicht einer Person B zu übertragen, wobei Details wie Mimik, Augenbewegungen und Lippenstellung erhalten bleiben. Diese Methode ist besonders effektiv für Gesichtstausch-Anwendungen und wird oft mit GANs kombiniert, um die Ergebnisse zu verfeinern. Technische Details bei Towards Data Science.

Der Erstellungsprozess im Detail

Die Herstellung eines Deepfakes ist ein komplexer, aber zunehmend zugänglicher Prozess, der mehrere Schritte umfasst:

- Datensammlung:

Hunderte bis Tausende Bilder oder Videos der Zielperson werden gesammelt, idealerweise aus verschiedenen Winkeln, mit unterschiedlichen Lichtverhältnissen und in verschiedenen emotionalen Zuständen (lächelnd, ernst, sprechend). Tools wie DeepFaceLab ermöglichen es, diese Daten effizient zu organisieren und vorzubereiten. Je mehr Material vorhanden ist, desto besser kann die KI die Nuancen der Person erfassen. - Trainingsphase:

Das Modell wird über Stunden, manchmal Tage, mit diesen Daten trainiert, oft auf leistungsstarken Grafikkarten wie NVIDIA GPUs. Währenddessen lernt die KI, Gesichtszüge, Bewegungen und sogar die Art und Weise, wie Licht auf die Haut trifft, zu reproduzieren. Dieser Schritt erfordert erhebliche Rechenleistung, ist aber dank Cloud-Diensten wie Google Colab auch für Hobbyisten erschwinglich geworden. NVIDIA über KI-Training. - Manipulation:

Das trainierte Modell wird dann verwendet, um das Gesicht auf ein Zielvideo zu projizieren. Dabei werden Lippenbewegungen mit der Audio-Spur synchronisiert, Hauttöne angepasst und Hintergrunddetails berücksichtigt. Dieser Schritt erfordert Präzision, da kleinste Fehler – wie ein unnatürlicher Übergang zwischen Gesicht und Hals – das Ergebnis unglaubwürdig machen können. - Nachbearbeitung:

Software wie Adobe After Effects oder spezialisierte KI-Tools werden eingesetzt, um Artefakte wie Unschärfen, Farbfehler oder Synchronisationsprobleme zu korrigieren. Dieser Feinschliff macht den Unterschied zwischen einem amateurhaften und einem professionellen Deepfake aus.

Hardware und Demokratisierung

Früher war die Erstellung von Deepfakes auf Supercomputer oder teure Server beschränkt, die nur Forschungsinstituten oder großen Unternehmen zur Verfügung standen. Heute reicht ein leistungsstarker Gaming-PC mit einer GPU wie der NVIDIA RTX 3080, um hochwertige Deepfakes zu erstellen. Cloud-Plattformen wie Google Colab oder AWS bieten sogar kostenlose oder kostengünstige Ressourcen, was die Technologie für Amateure zugänglich macht. Diese Demokratisierung hat die Verbreitung von Deepfakes exponentiell gesteigert – mit positiven wie negativen Folgen.

Teil 2: Anwendungsbereiche von Deepfakes

Unterhaltung und Kreativität

- Filmindustrie:

In „The Mandalorian“ wurde Luke Skywalker mittels Deepfake-Technologie verjüngt, um Mark Hamill in seiner Rolle aus den 1980er Jahren darzustellen (Hollywood Reporter). Ähnlich wurde Peter Cushing in „Rogue One“ posthum wiederbelebt, was zeigt, wie Deepfakes die Grenzen zwischen Vergangenheit und Gegenwart in der Filmkunst auflösen. - Social Media:

Virale Clips wie Jordan Peele’s Deepfake von Barack Obama, der scheinbar absurde Aussagen trifft, demonstrieren das kreative Potenzial (BuzzFeed Video). Solche Videos sind oft humorvoll gemeint, können aber auch als Warnung vor den Gefahren der Technologie dienen. - Kunst:

Künstler wie Mario Klingemann nutzen Deepfakes, um surreale, KI-generierte Werke zu schaffen, die die Grenzen zwischen Realität und Fiktion verschwimmen lassen (Artnet). Diese Arbeiten werfen Fragen zur Authentizität und menschlichen Kreativität auf.

Bildung und Wissenschaft

- Historische Rekonstruktion:

Projekte wie MyHeritage Deep Nostalgia erwecken alte Fotos zum Leben, indem sie Gesichter animieren. Museen könnten dies nutzen, um historische Figuren in realistischen Szenen darzustellen. - Sprachtraining:

KI-generierte Avatare könnten als virtuelle Lehrer dienen, die perfekt synchronisierte Lippenbewegungen zeigen und so das Sprachenlernen erleichtern (Lingoda über KI im Sprachunterricht).

Kommerzielle Nutzung

- Werbung:

Marken könnten Deepfakes einsetzen, um personalisierte Anzeigen mit prominenten Gesichtern zu erstellen, ohne diese physisch einbeziehen zu müssen. Das spart Zeit und Kosten (Forbes über KI in Werbung). - Virtuelle Influencer:

Lil Miquela, eine komplett generierte Influencerin, zeigt, wie Deepfakes die Grenzen zwischen Realität und Fiktion verwischen (Instagram).

Schattenseiten: Missbrauch und Desinformation

- Pornografie:

Laut Sensity AI entfallen 96 % der Deepfakes auf nicht einvernehmliche pornografische Inhalte, bei denen Gesichter von Prominenten oder Privatpersonen auf andere Körper projiziert werden. - Betrug:

Voice-Cloning wurde genutzt, um CEOs zu imitieren und Mitarbeiter zu täuschen, etwa bei sogenannten CEO-Betrügereien (Wall Street Journal). - Desinformation:

Gefälschte Videos von Politikern oder Ereignissen könnten Wahlen beeinflussen oder gesellschaftliche Unruhen schüren (Reuters über Deepfakes und Wahlen).

Teil 3: Ethische und gesellschaftliche Herausforderungen

Vertrauen in Medien

Deepfakes stellen eine Bedrohung für unser Vertrauen in visuelle und auditive Beweise dar. Wenn alles gefälscht sein könnte, wie können wir noch zwischen Wahrheit und Lüge unterscheiden? Der „Liar’s Dividend“ beschreibt ein weiteres Problem: Selbst echte Aufnahmen könnten als Deepfakes abgetan werden, um Verantwortung zu entgehen (Wired).

Privatsphäre und Einwilligung

Die Nutzung von jemandes Gesicht oder Stimme ohne Zustimmung wirft große ethische Fragen auf, besonders für Personen des öffentlichen Lebens, aber auch für Privatpersonen (Datenschutz.org).

Psychologische Folgen

Opfer von Deepfake-Missbrauch, insbesondere in pornografischen Kontexten, berichten von schwerwiegenden emotionalen Schäden (BBC). Gesellschaftlich könnten realistische Fälschungen Ängste oder Traumata auslösen.

Globale Ungleichheiten

Wohlhabende Länder entwickeln Detektoren, während ärmere Regionen anfälliger für Desinformation bleiben, was globale Ungleichheiten verschärft (Brookings Institution).

Teil 4: Rechtliche Rahmenbedingungen

Aktueller Stand

- USA:

Kalifornien hat Gesetze gegen Deepfake-Pornografie und politische Manipulation erlassen (California AB 730). - EU:

Die DSGVO bietet Schutz vor unbefugter Nutzung persönlicher Daten, doch spezifische Deepfake-Regulierungen fehlen (EUR-Lex). - Deutschland:

Verleumdung (§ 187 StGB) oder Persönlichkeitsrechtsverletzungen könnten greifen (Bundesministerium der Justiz).

Herausforderungen

- Nachweisbarkeit:

Es ist schwierig, die Urheberschaft gerichtsfest zu beweisen. - Grenzüberschreitender Charakter:

Online-Verbreitung erschwert die Zuständigkeit. - Technologischer Wettlauf:

Gesetze hinken der Entwicklung hinterher.

Lösungsvorschläge

- Internationale Abkommen (UNESCO über KI-Ethik).

- Verpflichtende Kennzeichnung von KI-Inhalten.

- Förderung von Detektoren.

Teil 5: Sensibilisierung der Öffentlichkeit

Warum Sensibilisierung entscheidend ist

Ohne Bewusstsein für Deepfakes bleibt die Gesellschaft verwundbar. Sensibilisierung schafft Medienkompetenz und schützt vor Täuschung.

Bestehende Kampagnen

- „Detect Deepfakes“ (USA):

Initiative von Facebook und Microsoft (Partnership on AI). - „Medienkompetenz“ (Deutschland):

Ressourcen der bpb (bpb Medienkompetenz). - EU-Projekte:

„InVID“ fördert Videoverifikation (InVID).

Ansätze für die Zukunft

- Schulunterricht:

Deepfake-Erkennung im Lehrplan. - Öffentliche Kampagnen:

Spots wie „Fake News können jeden treffen“ (ARD Mediathek). - Workshops:

Lokale Initiativen zur Medienkritik.

Teil 6: Deepfakes manuell erkennen

Visuelle Indikatoren

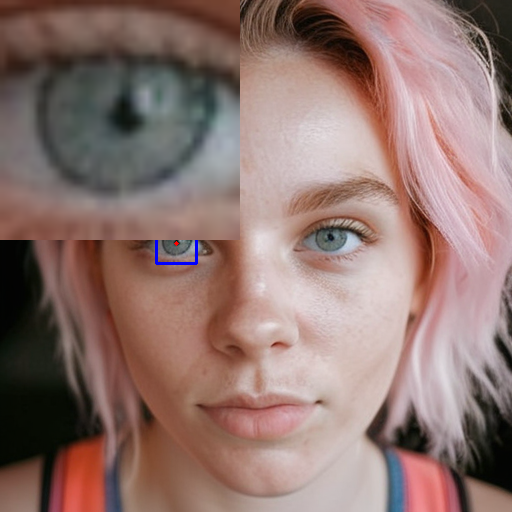

Ihr könnt Deepfakes auch ohne technische Hilfsmittel erkennen, wenn ihr wisst, worauf ihr achten müsst. Hier sind die wichtigsten visuellen Hinweise mit ausführlichen Erklärungen:

- Unnatürliche Bewegungen:

Deepfakes zeigen oft ruckartige, unnatürliche oder asymmetrische Bewegungen im Gesicht, die nicht mit der natürlichen menschlichen Mimik übereinstimmen. Beispielsweise könnten die Wangen unnatürlich zucken, während die Augen starr bleiben, oder die Stirn bewegt sich nicht synchron mit den Lippen. Dies liegt daran, dass KI-Modelle die komplexen Muskelbewegungen eines menschlichen Gesichts nicht immer perfekt nachbilden können – insbesondere bei schnellen oder subtilen Gesten wie einem Lächeln oder einem Stirnrunzeln. Schaut euch das Video am besten in Zeitlupe an, etwa mit einem Tool wie VLC Media Player, und achtet auf jede kleinste Abweichung. Oft fällt auf, dass Bewegungen „mechanisch“ wirken, als würden sie nicht organisch aus der Person selbst entstehen, sondern von einer Maschine gesteuert werden. Besonders bei älteren oder weniger aufwendigen Deepfakes ist dies ein offensichtlicher Hinweis. - Beleuchtungsfehler:

Inkonsistente Schatten oder Lichtreflexionen sind ein häufiger und verräterischer Hinweis auf einen Deepfake. Wenn das Licht auf dem Gesicht anders fällt als auf dem Hintergrund oder dem Körper, könnte etwas faul sein. Zum Beispiel könnte ein Schatten auf der rechten Gesichtshälfte fehlen, obwohl eine Lichtquelle von links sichtbar ist, oder die Reflexionen auf der Haut wirken unnatürlich stark oder schwach – etwa wie bei einer Plastikpuppe statt echtem Fleisch. Dies passiert, weil die KI die Beleuchtung nicht immer nahtlos an die Umgebung anpassen kann, insbesondere wenn das Originalvideo und das manipulierte Gesicht unter unterschiedlichen Bedingungen aufgenommen wurden. Achtet auch auf Details wie Haare: Wenn das Licht auf dem Gesicht glänzt, aber die Haare matt bleiben, ist das ein weiteres Indiz. Um dies zu prüfen, könnt ihr das Video pausieren und die Lichtverhältnisse mit bloßem Auge oder einem Bildbearbeitungsprogramm wie Photoshop analysieren. - Lippen-Synchronisation:

Wenn die gesprochenen Worte nicht exakt mit den Lippenbewegungen übereinstimmen, ist das ein starkes Zeichen für eine Manipulation. Bei Deepfakes können die Lippenbewegungen leicht verzögert, übertrieben oder sogar völlig unpassend wirken, besonders bei komplexen Sätzen oder ungewohnten Lauten wie „P“ oder „F“. Dies liegt daran, dass die KI zwar trainiert wird, Lippen mit Audio zu synchronisieren, aber oft an den feinen Nuancen scheitert – etwa wie sich der Mund bei einem Lächeln während des Sprechens verändert oder wie Zunge und Zähne kurz sichtbar werden. Hört genau auf die Audio-Spur und vergleicht sie mit dem Video: Wenn ein Wort wie „Hallo“ gesprochen wird, aber die Lippen sich nur für „Ha“ öffnen und dann stillstehen, ist das ein klarer Hinweis. Ihr könnt das Video frameweise abspielen, um diese Diskrepanzen zu erkennen, und auf subtile Details wie die Geschwindigkeit der Lippenbewegungen achten – sie wirken bei Deepfakes oft unnatürlich gleichmäßig oder abgehackt. - Hintergrundprobleme:

Verzerrungen oder Unschärfen rund um das Gesicht herum sind ein weiterer Hinweis auf Manipulation. Die KI hat oft Schwierigkeiten, den Übergang zwischen dem manipulierten Gesicht und dem Originalhintergrund nahtlos zu gestalten, was zu sogenannten „Halo-Effekten“ oder unscharfen Rändern führen kann. Beispielsweise könnten Haare plötzlich mit dem Hintergrund verschmelzen, als wären sie hineinkopiert, oder es erscheint eine leichte Unschärfe um den Kopf, die im restlichen Bild nicht vorhanden ist. Dies tritt besonders auf, wenn das Originalvideo eine komplexe Umgebung hat – etwa bewegte Objekte oder wechselndes Licht. Achtet auch auf Details wie Ohren oder den Hals: Wenn diese Bereiche unscharf oder verzerrt wirken, während der Rest des Bildes klar ist, könnte das ein Zeichen sein. Um dies zu überprüfen, könnt ihr das Video vergrößern und die Ränder des Gesichts genau inspizieren – oft sind diese Fehler mit bloßem Auge sichtbar, besonders bei Amateur-Deepfakes. - Deformierte Augen:

Augen sind einer der schwierigsten Bereiche für KI, da sie feine Details wie Pupillen, Iris und Wimpern enthalten, die schwer zu fälschen sind. Deepfakes zeigen daher oft deformierte oder unnatürlich geformte Augen – etwa ovale statt runde Formen, ungleichmäßige Pupillen oder sogar Augen, die leicht verschwommen wirken. Dies entsteht, weil die KI die komplexe Struktur der Augen nicht perfekt abbilden kann, insbesondere bei Bewegungen wie Blinzeln oder einem Seitenblick. Manchmal sehen die Augen auch „tot“ aus, ohne die natürliche Lebendigkeit, die echte Augen durch Lichtreflexionen und feine Muskelbewegungen haben. Schaut genau auf die Augenpartie, idealerweise mit einem Zoom-Werkzeug, und achtet auf jede Abweichung – selbst kleine Unregelmäßigkeiten wie eine unnatürliche Krümmung der Augenlider können ein Hinweis sein. Dies ist besonders auffällig, wenn die Person den Kopf dreht oder die Augen schnell bewegt. - Verschiedene Reflexionen in den Augen je Auge:

Ein subtiler, aber extrem verräterischer Hinweis sind unterschiedliche Lichtreflexionen in jedem Auge. In echten Videos reflektieren beide Augen das Licht der Umgebung gleichmäßig – etwa ein kleiner weißer Punkt von einer Lampe oder ein diffuses Schimmern bei Tageslicht. Bei Deepfakes kann jedoch ein Auge eine andere Reflexion zeigen als das andere, z. B. ein scharfer Lichtpunkt in einem Auge und ein verschwommener Streifen im anderen. Dies liegt an Inkonsistenzen in der KI-Rendering-Engine, die das manipulierte Gesicht nicht perfekt mit der Originalumgebung abstimmt. Um dies zu erkennen, pausiert das Video bei einem Moment, in dem Lichtquellen sichtbar sind, und vergleicht die Reflexionen in beiden Augen. Wenn sie nicht übereinstimmen – etwa in Form, Größe oder Helligkeit –, ist das ein starkes Indiz für eine Fälschung. Dieser Fehler wird oft übersehen, ist aber mit etwas Übung leicht zu identifizieren. - Unstimmigkeiten bei der Haut:

Hauttöne oder Texturen können uneinheitlich wirken und so einen Deepfake verraten. Beispielsweise könnte das Gesicht glatter oder rauer als der Hals erscheinen, oder es gibt sichtbare Übergänge zwischen manipulierten und echten Bereichen – etwa eine Linie, wo die Hautfarbe plötzlich wechselt. Auch unnatürliche Hautfarben wie zu blass, zu rot oder sogar ein leicht grünlicher Schimmer sind ein Hinweis, da die KI manchmal die natürliche Pigmentierung nicht korrekt anpasst. Dies tritt besonders auf, wenn das Originalvideo und das manipulierte Gesicht unter unterschiedlichen Lichtbedingungen entstanden sind. Achtet auch auf Details wie Poren oder Falten: Wenn das Gesicht unnatürlich glatt wirkt, während der Hals natürliche Unebenheiten zeigt, könnte das ein Zeichen sein. Um dies zu prüfen, könnt ihr das Bild vergrößern und die Hautstruktur genau analysieren – oft sind diese Unterschiede subtil, aber mit etwas Aufmerksamkeit erkennbar.

Auditive Indikatoren

Auch die Tonspur kann Deepfakes entlarven – hier sind die Details:

- Stimmverzerrungen:

Unnatürliche Tonlagen, plötzliche Änderungen im Klang oder synthetische Untertöne deuten auf Voice-Cloning hin. Hört auf kleine „Roboter“-Artefakte – etwa ein leichtes Zischen oder ein metallischer Nachklang –, die bei menschlichen Stimmen nicht vorkommen. Auch unnatürliche Pausen oder ein zu gleichmäßiger Rhythmus können auffallen, da echte Sprecher ihre Tonlage und Geschwindigkeit je nach Emotion variieren. Bei Deepfakes fehlt oft diese natürliche Dynamik, besonders bei längeren Sätzen oder emotionalen Passagen. Spielt die Audio-Spur separat ab – etwa mit Audacity – und achtet auf jede Abweichung von der erwarteten Stimmqualität. Wenn die Stimme plötzlich „flach“ oder künstlich klingt, könnte sie manipuliert sein. - Hintergrundgeräusche:

Plötzliche Änderungen im Hintergrundklang – z. B. ein Wechsel von Stille zu Rauschen oder das Verschwinden eines konstanten Tons wie Verkehrslärm – können Manipulationen verraten. Echte Videos haben meist konsistente Umgebungsgeräusche, die mit der Umgebung übereinstimmen, während Deepfakes diese nicht immer sauber integrieren. Beispielsweise könnte ein Vogelgezwitscher mitten im Satz verschwinden, obwohl die Szene draußen spielt, oder ein Echo taucht auf, das zur sichtbaren Umgebung nicht passt. Hört genau auf die Tonspur und vergleicht sie mit dem Video: Wenn die Geräusche nicht mit den sichtbaren Bewegungen oder der Umgebung synchron sind, ist das ein Hinweis. Dies erfordert etwas Übung, kann aber mit Tools wie Audacity präzise überprüft werden.

Praktische Schritte zur manuellen Analyse

- Vergleich mit Originalen:

Sucht bekannte Videos der Person auf Plattformen wie YouTube oder X und vergleicht Bewegungen, Stimme und Details wie Narben, Muttermale oder charakteristische Gesten. Achtet darauf, ob die Person im fraglichen Video die gleichen Eigenheiten zeigt – etwa eine typische Kopfneigung oder Sprechweise. - Vergrößerung:

Nutzt Tools wie Photoshop oder einfache Bildbetrachter, um auf Augen, Mund oder Haut zu zoomen und Unregelmäßigkeiten wie Deformationen oder Übergänge zu finden. Dies ist besonders nützlich, um subtile Fehler wie unnatürliche Reflexionen oder Hauttexturen zu entdecken. - Zeitlupe:

Spielt das Video frameweise ab, z. B. mit VLC Media Player, um Bewegungen, Synchronisation und Details wie Blinzeln oder Lippenbewegungen genau zu prüfen. Dies erfordert Geduld, aber jede kleine Diskrepanz kann entscheidend sein.

Grenzen der manuellen Erkennung

Mit fortschreitender Technologie werden Fehler immer subtiler. Laien stoßen schnell an ihre Grenzen, besonders bei professionellen Deepfakes, die mit modernen Tools und Nachbearbeitung erstellt wurden (WIRED über Erkennungsschwierigkeiten).

Teil 7: Automatisierte Erkennung und Indikatoren

KI-basierte Detektoren

Automatisierte Tools sind unerlässlich, um mit der Flut an Deepfakes Schritt zu halten – hier sind die wichtigsten:

- Microsoft Video Authenticator:

Dieses Tool analysiert Videos frameweise auf Manipulationen wie unnatürliches Blinzeln, Pixelartefakte oder Synchronisationsfehler. Es wurde entwickelt, um Journalisten und Faktencheckern zu helfen, und ist besonders effektiv bei Social-Media-Clips (Microsoft). - Deepware Scanner:

Ein Open-Source-Tool, das Deepfakes anhand von visuellen und strukturellen Anomalien erkennt. Es ist kostenlos verfügbar und eignet sich für Laien wie Experten (Deepware). - Sensity AI:

Spezialisiert auf pornografische Deepfakes, bietet es detaillierte Analysen von Gesichtsmanipulationen und wird von Unternehmen genutzt, um schädliche Inhalte zu identifizieren (Sensity). - DNID Deepfake Scanner:

Mein eigener Deepfake-Scanner mit Fokus auf Videos, entwickelt um subtile Manipulationen in Bewegungen, Lippen-Synchronisation und Hauttexturen zu erkennen. Er ist darauf ausgelegt, sowohl Amateur- als auch professionelle Deepfakes zu identifizieren, indem er auf Details wie unnatürliche Augenbewegungen oder Hautübergänge achtet. Probiert ihn aus unter https://dnid.me/. Besonders nützlich ist er für die Analyse von Social-Media-Clips, da er eine benutzerfreundliche Oberfläche bietet und schnell Ergebnisse liefert. Ich habe ihn mit einem speziellen Algorithmus ausgestattet, der auf Video-spezifische Artefakte abzielt, was ihn von anderen Tools abhebt.

Spezifische Indikatoren

- Blinking-Anomalien:

Deepfakes zeigen oft unnatürliches oder fehlendes Blinzeln, da frühere Modelle dieses Detail vernachlässigten. Menschen blinzeln etwa 15-20 Mal pro Minute, und jede Abweichung davon – etwa zu schnelles, zu langsames oder gar kein Blinzeln – kann ein Hinweis sein. Moderne KI wird zwar besser, aber minimale Abweichungen bleiben erkennbar, etwa ein leicht verzögerter Lidschlag oder eine unnatürliche Gleichmäßigkeit. Tools wie der DNID Scanner oder Microsofts Video Authenticator können diese Anomalien automatisch erkennen, indem sie die Frequenz und Natürlichkeit des Blinzelns analysieren (Scientific American). - Pixel-Artefakte:

Übermäßige Glättung oder Rauschen in bestimmten Bereichen – etwa um Augen, Mund oder Haare – entsteht durch KI-Interpolation, wenn das Modell versucht, manipulierte Bereiche mit dem Originalbild zu verschmelzen. Diese Artefakte können als winzige Unschärfen, unnatürliche Kanten oder ein „digitaler Schleier“ erscheinen, besonders bei niedriger Videoqualität. Fortgeschrittene Detektoren wie DNID oder Deepware analysieren Pixelmuster und erkennen solche Unregelmäßigkeiten, die für das menschliche Auge oft schwer sichtbar sind. Um dies manuell zu überprüfen, könnt ihr das Video vergrößern und auf unnatürliche Übergänge achten, aber automatisierte Tools sind hier deutlich präziser. - Metadaten:

Fehlende oder inkonsistente Dateiinformationen – etwa falsche Zeitstempel, ungewöhnliche Komprimierungsspuren oder fehlende Kamera-Details – sind ein Hinweis auf nachträgliche Bearbeitung. Echte Videos enthalten oft Metadaten, die mit der Aufnahmezeit und dem Gerät übereinstimmen, während manipulierte Dateien diese Informationen verlieren oder verfälschen können. Tools wie ExifTool können Metadaten auslesen, und Detektoren wie Sensity AI nutzen diese Daten, um Manipulationen zu bestätigen. Dies ist besonders nützlich bei Videos, die über mehrere Plattformen geteilt wurden, da jede Bearbeitung Spuren hinterlässt.

Blockchain-Lösungen

Digitale Signaturen könnten die Echtheit von Videos garantieren, indem sie unveränderbare Metadaten wie Zeitstempel oder Ursprungsdaten einfügen. Blockchain-Technologie wird hier als eine Art „digitaler Fingerabdruck“ eingesetzt, der Manipulationen sichtbar macht. Unternehmen wie Truepic arbeiten an solchen Lösungen, und sie könnten in Zukunft Standard für verifizierte Medien werden (CoinDesk über Blockchain).

Teil 8: Dokumentationen über Deepfakes

- „The Deepfake Dilemma“ (BBC, 2023):

Untersucht die Auswirkungen auf Gesellschaft und Politik (BBC iPlayer). - „Welcome to the Deepfake Era“ (Netflix, 2022):

Über Technologie und Risiken (Netflix). - „Faking It: Deepfakes und Desinformation“ (Arte, 2021):

Fokus auf Desinformation (Arte Mediathek). - „The Truth About Deepfakes“ (DW, 2023):

Ethik und Recht aus deutscher Sicht (DW).

Teil 9: Zukunftsperspektiven

- Echtzeit-Deepfakes:

Manipulationen live in Videoanrufen (The Verge). - Multimodale Fälschungen:

Kombination aus Video, Audio und Text. - Gegenmaßnahmen:

KI-Detektoren und Wasserzeichen.

Schreibe einen Kommentar